从0到1实战微服务架构(第2版)

地址汇总

第2版前言

自从本书发布了后,技术圈发生了许多变化:

- Spring Boot 2.X 稳定版发布

- Kubernetes下的包管理项目“Helm”,正式加入CNCF基金会

- 阿里巴巴开源了Nacos服务发现项目

- ......

3年后的2021年,我正式开启了本书2.0版的写作计划。

由于技术更新迭代频繁,这是一次完全的重写,不是修订。

由于gitbook项目已不再维护,我改用mdBook做为渲染工具,MarkText做为写作工具。

写作水平有限,还请各位多提宝贵意见。

第1版前言

微服务是继SOA后,最流行的服务架构风格之一。

按照微服务对系统进行拆分后,每个服务的业务逻辑都更加简单、清晰。服务之间是松耦合的,模块之间的边界也更加清晰。

微服务有效降低了软件项目的业务复杂程度,为小团队独立开发、持续交付和部署打下了良好的基础。

遗憾的是,微服务并不是银弹。与传统的单一架构相比,微服务架构对团队的组织架构、技术水平、运维能力等方面,都提出了更高的要求。如果没有掌握得当的方法而生搬硬套,微服务架构只会会适得其反--降低项目的开发效率,这是本书的创作初衷之一。

在国内外的技术社区中,比较推崇现有开源方案,如"Spring Cloud全家桶"或者阿里开源的"Dubbo"。

上述框架通常已经实现了服务发现、配置、负载均衡、限流熔断,等微服务架构所必须的的核心功能。

使用开源框架省却了造轮子的过程,但也降低了我们学习、思考的动力。

为什么需要服务发现,又如何实现它呢?配置中心呢....思考和设计的过程充满了挑战,也是提升自身架构能力的一种手段。这是本书的创作初衷之二。

已有的微服务资料过于重视微服务的开发,忽略了微服务赖以生存的生态系统:工具链、自动化运维。可以说,离开了这两点的支持,微服务架构将难以落地。完善这两方面的思考和实战,是本书的创作初衷之三。

为此,我撰写了这本《从0到1实战微服务架构》。让我们"暂时忘掉"已有的、成熟的开源解决方案。尝试亲自动手,实现微服务架构的各个模块。

我们会从微服务开发、工具链、运维这三个角度,阐述微服务架构的实战方案。

如果本书帮助了你,欢迎在在github加Star,但严禁用于商业用途!(参见本页底部版权声明)

由于能力水平所限,本书难免存在各种错误,恳请各位进行指正(Issue or PR),谢谢!

读者基础

由于篇幅、精力所限,本书无法写成一本”零起点”教程。我假设读者具有至少2年的服务端工作经验,并且了解以下技术或原理:

- Git

- Maven & Gradle

- Docker & Kubernetes

- Java

- Spring / Spring Boot

- 数据库: 如MySQL

- 消息队列: 如RabbitMQ

- 缓存系统: 如Memcached

- 内存数据库: 如Redis

本书可以供架构师、项目经理、高级服务端程序员参考、学习。

动手实战是本书的核心内容,因此本书所涉及的全部代码,都托管到了我的Github上(以lmsia-开头的项目)。

这些代码以研讨为主要目的,也可以直接应用于生产,但本人不对其稳定性负责。

版权

本书虽然在github上公开写作,但版权归本人Coder4所有。

依照 署名-非商业性使用-相同方式共享 ,任何人可以在保留署名的情况下转载。但严禁用于商业用途。

This is a book powered by mdBook.

微服务概述

什么是“微”服务?

如果你仔细观察,会发现我在上一行的标题中,将“微”打了个引号。

如果我们暂时去掉这个''微"字理解,微服务就是我们熟知的“服务端” 或者 “后端”。

现在让我们把微字加回来:-)

"微服务"(Microservices)由马丁·福勒(Martin Fowler)提出的一种架构理念,原文发表于2014年。

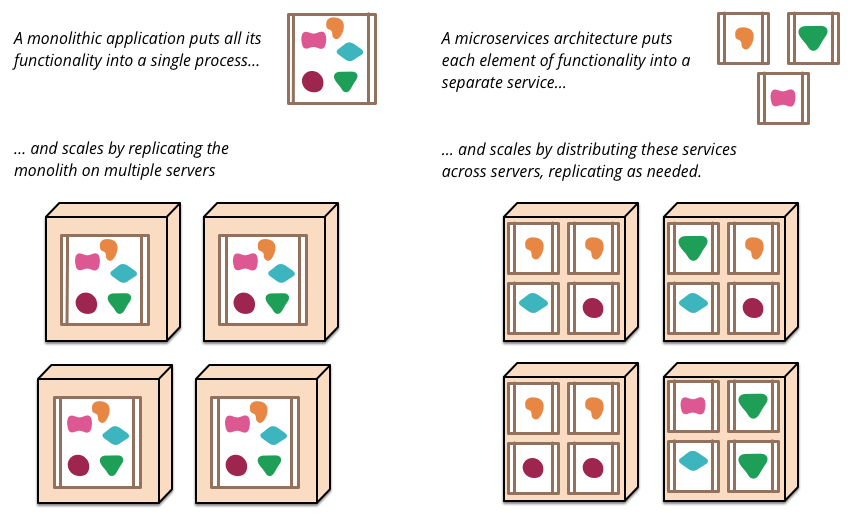

微服务是一种架构模式或者说是一种架构风格,它提倡将单一应用程序划分成一组小的服务,每个服务运行独立的自己的进程中,服务之间互相协调、互相配合,为用户提供最终价值。

我们抓三个关键点来理解:

-

单一应用划分为一组更小的服务:将一个较大的、复杂的应用,拆分为多个小的服务。你可能会问:“这样不会增加复杂度么”?是的,会增加。但这种拆分也会带来明显的优点,我们后面会提到。

-

独立的进程:每个微服务独立运行在自己的进程中,互不干扰。虽然这里并没有限制进程的部署方式,但可以想见,经过"划分"后的微服务,势必会产生众多进程。微服务是拆分而来的,他们之间势必存在逻辑的耦合。由此,会产生新的问题"微服务间的通信"。

-

相互协调、配合:微服务的进程间需要通信、交互。从理论而言,所有IPC(Inter-Process Communacation,进程间通信)的方式都可以完成这个过程。但微服务的进程众多,很难完整地部署在同一台机器上,这势必产生跨主机的网络通信。所以,在微服务中,多采用RPC(Reomote Procedure Call,远程过程调用)的方式来完成通信。

上图展示了单体服务 和 微服务的区别。

为什么需要微服务?

在前文中,我们挖了一个坑:'微服务的划分会导致复杂度上升',为什么还要使用一项有缺陷的技术呢?

我们先讲第一个故事。

小张入职了一家互联网创业公司,一开始只有3个后端程序员,每天的工作是:和产品经理讨(si)论(bi)需求、写代(b)码(ug),改Bug,工作紧张但规律。服务端的上线窗口是周五下午:合并分支、代码Review、推送线上,一气呵成,不仅能准点下班,还能去吃个火锅。

过了两个月,行业赶上了风口,公司的业务快速发展,后端团队也快速膨胀到20人。然而,麻烦也接踵而至:大家修改的是同一个仓库下的服务端代码,"解冲突"成为了家常便饭,还发生了几次"一个小修改,破坏了其他业务主流程“的严重线上事故。

为了改善这种情况,老板招聘了2位QA(质量保证,测试)人员,由他们负责测试工作。然而,一个很小的改动都需要对整个后端服务的case进行全量回归测试。一个功能的开发需要1天,测试却耗费1周,迫于老板的压力,研发同学只能安慰自己:XX功能简单,不需要测试了,直接上线。

最终,周五成为了"噩梦日":周四晚上要提前开一个Excel表、统计好第二天要上线的需求,并按优先级排定顺序。周五全员提前1小时来公司,开始逐个逐个需求的"合并代码"”、"解冲突",“上线”、"观察" 、“回滚”、“修改代码”......

上线结束的收工时间从6点变成了9点,又逐渐拖到了11点,最后索性全员加班、通宵上线。技术团队的每一位同学,都感到身心俱疲。

听完这个故事,你是否有"似曾相识"的感觉?

科普一下,上述故事中的服务一般称作“单体服务” 或者 “巨石服务”(Monoliths)。

接下来,是第二个故事。

由于工作强度大、线上故障频发、团队士气低落,老板请来了老刘担任技术经理。

第一周:老刘带领团队将复杂、臃肿的"巨型服务"拆分成了“用户”、“订单”、“服务”三个微服务。

第二周:老刘将团队进行了上述类似的拆分,也分成了三个小组。

第三周:事情有了微妙的变化。分组后,合并代码引发的冲突减少了。开发业务时,多数的改动都封闭在单独的微服务内,改动造成的影响范围减少了,测试周期缩短了。

......

三个月后的一个周五的下午,(得益于提高的交付质量,以及微服务的独立并行上线),团队提前2小时完成了上线,距离上一次故障通报已经过去了两个月。

研发讨论群里,小张发了一条消息:“今天居然可以正点下班了,老刘真厉害!”

老刘回复:这是大家的努力的结果,真正“厉害”的应该是“微服务”。

听完这两个故事,我们来总结下微服务架构的两个优点:)

-

逻辑清晰:一个微服务只负责一项(或少数几项)很明确的业务,逻辑更加简介清晰,易于理解。

-

独立自治:每个微服务由一个小组负责。减少了跨团队的代码冲突,同时降低了改动的影响范围,提高了研发效率。

在故事之外,微服务架构还具有以下的优点:

-

伸缩性强:相对于庞大的巨石服务,微服务更加独立,可以针对不同的性能需求,有选择的对不同微服务进行伸缩。举个栗子:明天有大促,产品预测:注册功能提升10倍,其他功能无波动。针对巨石服务,我们只能整体扩容10倍;微服务架构下,我们只需要10倍扩容用户微服务。

-

技术异构性:每个微服务内可以使用不同的技术栈,甚至不同的开发语言。只要微服务之间使用统一的通信方式即可。

微服务架构有很多优势,那团队抓紧上马微服务吧?

微服务是“银弹”么?

直接泼一盆冷水:

There is no Silver Bullet. -- 《人月神话》

微服务不是“银弹”,它存在以下缺点:

-

复杂度升高:在巨石服务中,所有修改都集中在同一个项目内;在微服务架构下,复杂功能的开发,需要同步修改多个微服务,复杂度骤然升高。

-

性能损耗:原本在巨石服务中的方法调用,演变为微服务之间的跨进程、网络通信。性能会受到较大影响。

-

可靠性陷阱:假设每个服务的可靠性都是99%,一个巨石服务,可靠性是99%、三个微服务的可靠性会下降到99% x 99% x 99% = 97%。

-

运维难度加大:巨石服务被拆分成N个微服务,部署的数量翻倍的增长。此外,多组微服务的运行,也会增大运维、监控的难度。

有意思的是:"拆分"带来了优点,也引入了缺点。

夫尺有所短,寸有所长,物有所不足,智有所不明。 -- 《楚辞.屈原.卜居》

微服务架构也是如此,它的优缺点并存。

微服务适用什么场景?

什么场景适用微服务,什么场景不适用呢?

这篇文章[《When to use and not use microservices》](Best of 2020: When To Use - and Not To Use - Microservices - Container Journal)给出了一些建议:

适用微服务架构的场景:

-

希望巨石服务能适应“可扩展性”、“敏捷性”、“可管理性”,提升交付速度时

-

需要为(使用陈旧技术开发的)的老系统,迭代新功能时

-

有一些相对独立的模块可以跨业务复用时:如登录、检索、身份验证等。

-

构建需要快速交付、创新度高、敏捷的应用 / 服务

不适用微服务架构的场景:

-

业务简单,无需处理复杂问题

-

团队规模太小,尚无法负担微服务拆分带来的复杂度提升

-

为了微服务而微服务

最后,引用马丁·福勒(Martin Fowler)论文的结尾做结束本节的讨论。

我们怀着谨慎、乐观的态度写了这篇文章。到目前为止,我们已经看到:微服务风格是一条非常值得探索的路。我们不能肯定地说,我们将在哪里结束,但软件开发的挑战之一是,你只能基于目前能拿到手的、不完善的信息作出决定。

微服务研发工具链

子曰:“工欲善其事,必先利其器。居是邦也,事其大夫之贤者,友其士之仁者。”

-- 《论语》

普通话版:工匠想要做好工作,先要把工具打磨锋利。

程序员版:软件工程师要想写好代码,需要一把机械键盘,并定期清洗轴以维持最佳手感。

对于程序员而言,除了键盘等硬件,还有一系列软件。我们这里将这些软件称为工具链。

小王的一天

下面,让我们跟随小张 - 是的,就是在风口创业公司的那位 - 看看在微服务架构下,研发工具链包含了哪些内容。

| 时间 | 工作 | 工具需求 | 备注 |

|---|---|---|---|

| 09:01 | 打开浏览器,登录公司内网 | 使用同一个账号,登录公司所有的内部系统。 | 暂不讨论“操作系统”、“浏览器”等通用软件。 |

| 09:03 | 打开代码审核平台,查看Review | 代码版本控制、代码托管,代码审核 | |

| 10:23 | 老张让我升级下xx的包,加了新接口 | 版本依赖管理系统 | 我们将开发语言暂时限定为Java |

| 11:56 | 修改了一部分逻辑,午饭前抓紧提交上去,看能否跑通所有Case | 持续集成(Continuous integration)系统 | 暂不讨论“IDE”等通用软件。 |

| 15:20 | 功能开发完毕,上线! | 持续交付(Continuous delivery)系统 | |

| 16:03 | X功能重构,拆分到两个微服务中 | 微服务开发辅助工具 |

研发工具链

小张的公司还处于创业阶段,出于节省成本的考虑,我们尽量选择开(mian)源(fei)的解决方案:

-

内部帐号统一管理:在企业的内部,存在许多内部系统。出于安全性、管理性的考虑,需要统一的帐号管理系统。这里我们选用OpenLDAP:一款的开源的帐号管理服务,它实现了广泛使用的“轻量级目录管理协议”(LDAP v3),可以轻松对接各类系统的帐号管理功能。

-

代码管理:团队协作的软件开发模式,需要版本控制系统。我们选用了Git做为代码的版本控制系统。在代码的托管、审核方面,Gerrit和GitLab都是成熟的开源解决方案。Gitlab上手容易,生态链更加成熟;Gerrit有一定上手门槛,在代码Review方面更加优秀。关于两者的讨论,可以参考这篇帖子。经过多方面的综合考虑,我们选择了GitLab。

-

版本依赖系统:在Java开发中,Maven是依赖管理的事实标准。同时在企业开发中,不希望将私有包发布到公开仓库中,我们选用Nexus Repository OSS搭建私有的Maven仓库。

-

持续集成、持续交付,持续部署是三个既相近又重要的概念,我们将在下一小节展开讨论。

-

微服务辅助开发工具:在微服务架构下,新增微服务、升级pom版本,接口变更等操作会频繁发生。需要开发一些辅助工具,提升研发效率。我们会在后面展开讨论。

针对上述选择的工具,我们会在后续章节详细介绍。

微服务辅助开发工具

结合微服务的开发特点,我们需要这样一些辅助工具:

-

自动创建新的微服务:包括从模板项目生成微服务代码、自动创建git项目、部署项目

-

RPC桩文件生成:在RPC的(IDL)接口文件变更后,需要重新生成桩文件,这个步骤较为繁琐,需要工具辅助完成。

-

pom版本自动升级:微服务之间的版本依赖,更新会更加频繁,我们需要一个工具,自动修改pom版本

这里我们只初步讨论一下需求,具体的实现会在后续章节展开。

持续集成、持续部署、持续交付

标题里的三个“持续”在前几年特别火热,属于技术热词(BuzzWord)。

持续交付(Continuous Delivery)由马丁·福勒(Martin Fowler)于2006年提出。

是的,你没看错,又是马丁·福勒,那位提出微服务的大神。

歪个楼,介绍一些马丁·福勒的代表作:

-

《重构:改善既有代码的设计》

-

《企业应用架构模式》

-

《敏捷软件开发宣言》(联合)

-

“微服务”、“持续部署” ....

以上任何一条单独拿出来,都足以封神。

言归正传,我们在一本“微服务”的书中讨论持续交付,仅仅因为它是由大神提出的么?

当然不是,我们将在本文的末尾再讨论这个问题。

这篇文章很好的阐述了三个概念的联系与区别,我们展开讨论。

持续集成

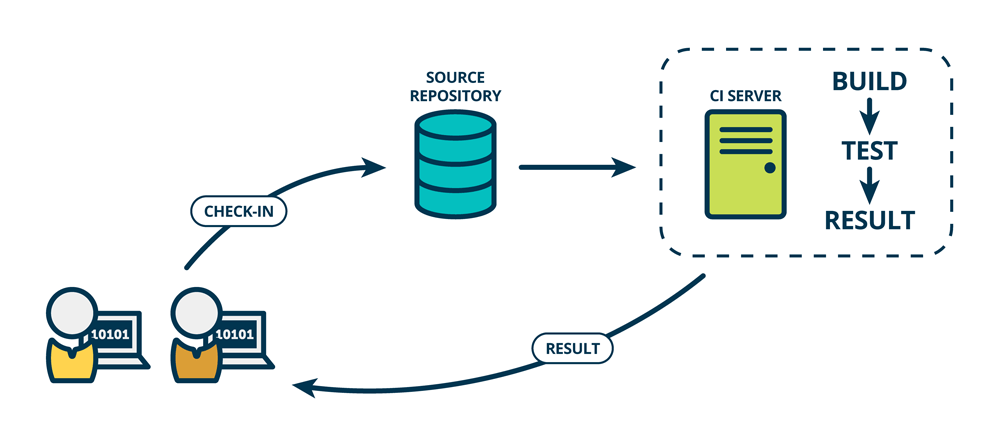

小王每次向gitlab提交一个代码,就会触发一次项目的自动构建、运行单元测试,这就是持续集成(Continuous Integration)。如下图所示:

假设小王在提交中引入了一个Bug,借助CI流程(中的集成 or 单元测试),我们就能在第一时间发现,并尽早修复问题。

管理学大师戴明指出:“问题发现的越早,修复的成本越低”。通过持续集成,我们可以尽早发现问题,从而降低(修复问题带来的)返工成本。

持续部署

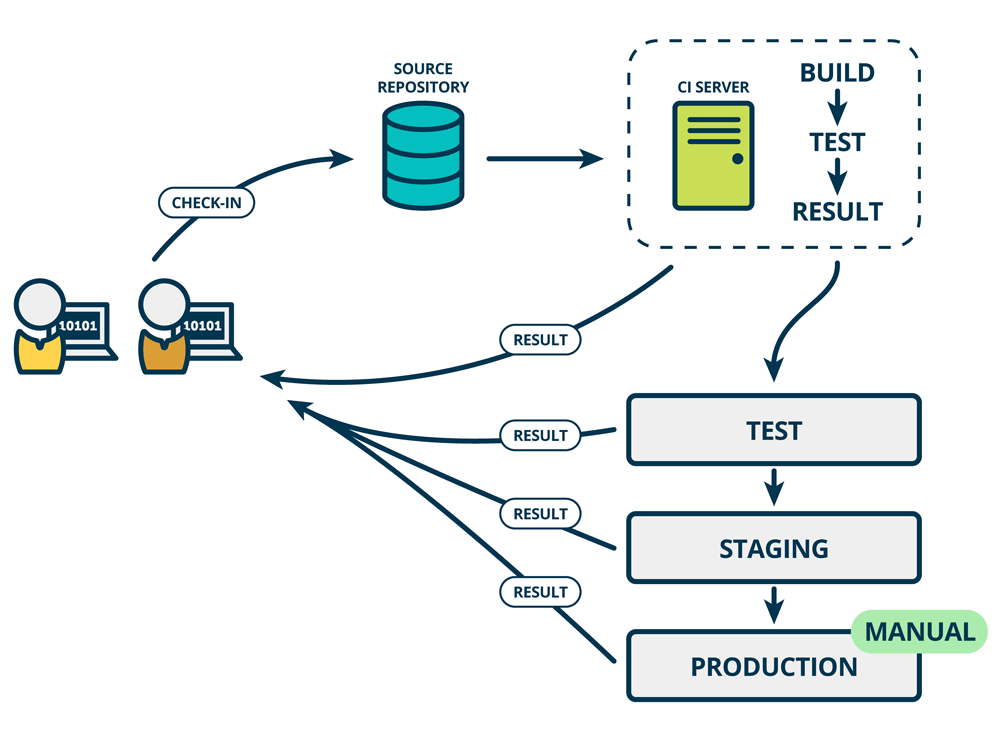

持续部署(Continuous Deployment)指的是:在持续集成(成功)的基础上,自动将服务部署到"类似于线上"的环境中,如下图所示:

为什么要部署到"类似于线上环境"呢?因为代码只在"集成阶段"通过了一部分"单元测试",假设单元测试覆盖不全,甚至还需要人工测试,那就可能将隐含的Bug发布到线上,造成生产事故。

图中画的"TEST"(测试环境)、"STAGING"(预发环境),都是这类"类似线上环境"。当新版本通过最终确认后,再手动(MANUAL)部署到线上。

持续交付

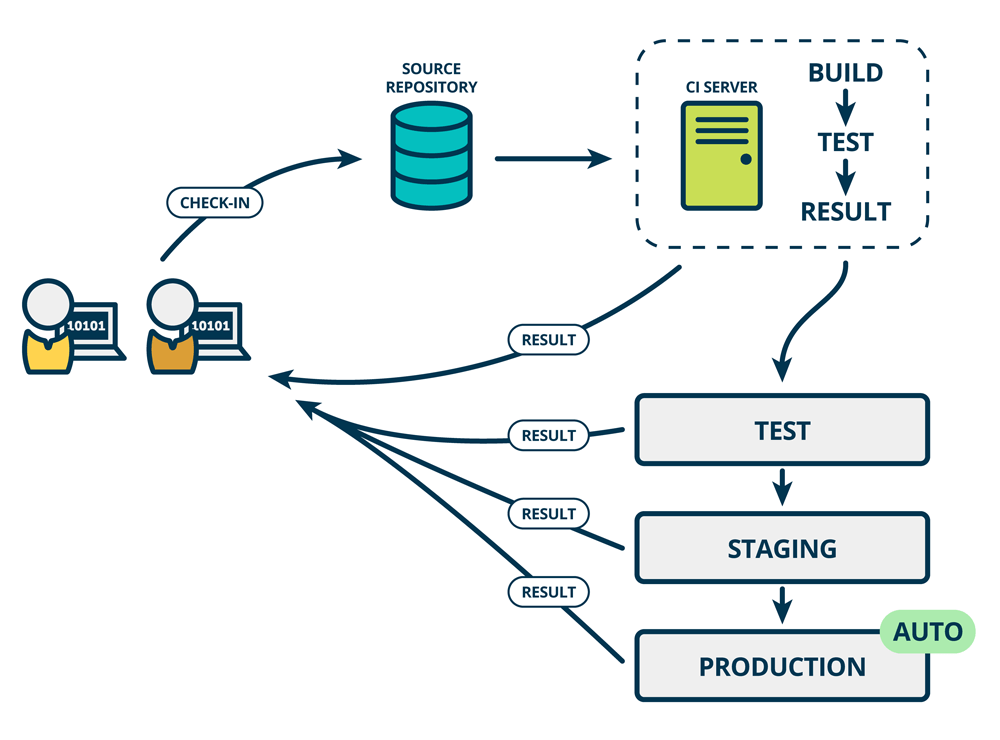

持续交付(Continuous Delivery)在持续部署的基础上,更近了一步:成功发布到"类似生产环境"后,会继续自动发布到线上,如下图所示:

显然,这种"自动发布"需要极强的自信和勇气。这可能源于充分的单元测试,清晰的架构,以及对业务能力的自信。

实际上业界只有极少数公司"从容地"实现了上述意义上的"持续交付"。

其余宣称实现了"持续交付"的公司,或者混淆了持续部署的概念,或者对技术故障存在较大容忍度。 (先发布再灰度,难道不是一种容忍?)

这并不是高级黑,如果你认真做过一段时间软件开发,应该能明白“即使100%的单测覆盖率,也不能自动检查出尚未发现的Bug”,更何况绝大多数项目根本无法达到100%单元覆盖率。

我们回到本文开头的问题:为什么要在一本“微服务”的书中,讨论持续部署?

还记得微服务概述一节中,微服务的缺点么?可靠性陷阱、运维复杂度升高。

-

借助持续集成,能够尽早发现缺陷,提升微服务架构下的可靠性。

-

应用持续部署,可以上线效率,降低运维难度。

由此可见,持续集成、持续部署,能够切实解决微服务中存在的问题。我们将在本书的后续章节,打造自己的持续集成系统,敬请期待。

一种微服务的分层架构

在上一小节,我们讨论了微服务架构“的的特征、优缺点等话题。

你可能对微服务有了一个模糊的概念,依然感觉不够清晰。

这种感受能够理解。因为,微服务的理论只是提供了一种“架构风格”的建议,并不包含具体的实施方案。

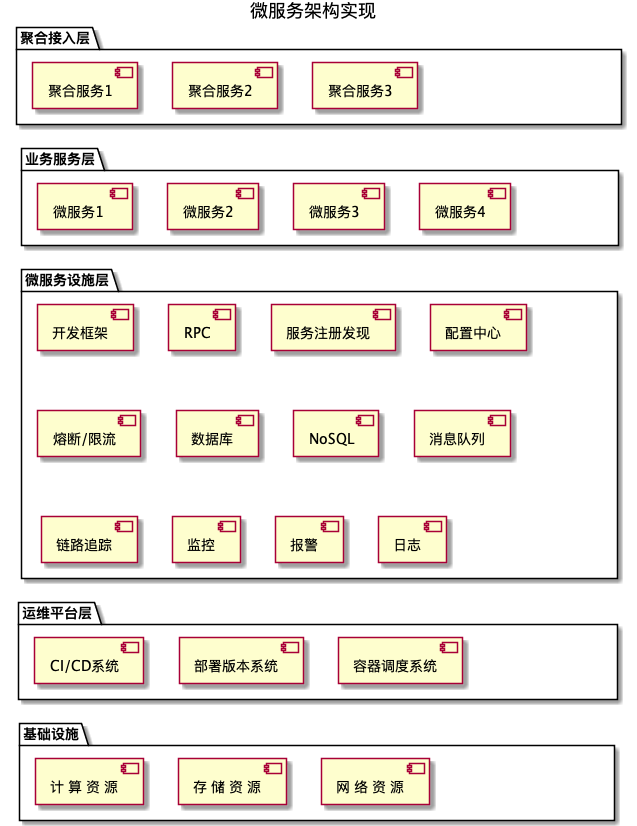

下图展示了一种微服务的分层架构:

让我们自底向上、逐层分解:

-

基础设施层

基础设施层涵盖了服务端运行时,所需要的物理资源。包括:计算资源、存储资源、网络资源等。

针对小型公司,可以直接选用云计算平台的资源(如阿里云、AWS等);中大型公司出于成本、审计等因素,会自建机房或混合云。

计算资源:CPU、GPU、内存等。除了CPU的核数、内存容量,配比等常见问题,还需要考虑计算资源的弹性伸缩能力,即如何应对“平台大促”等场景带来的流量提升。

存储资源:不仅要考虑磁盘容量,还要考虑磁盘性能([IOPS](IOPS - 维基百科,自由的百科全书))。举个例子:服务端日志主要是顺序写,异步处理 + 大容量机械磁盘就能满足要求;对MySQL等数据库场景,涉及大量随机读,使用SSD可以显著提升性能。

网络资源:外网带宽(峰值)、内网带宽、负载均衡、VPC等。内外网带宽问题较为常见,我们不再讨论。负载均衡:当业务流量规模升高后,接入层的传统软负载解决方案(Nginx、LVS)会显得力不从心。硬件负载均衡(F5)可以提供更高的性能,但做为专用计算的商业产品,其价格在百万以上。这几年,随着Kernel By Pass技术的兴起,基于X86通用硬件 + Linux的的软负载均衡也取得一定的性能突破,感兴趣的话,可以参考这篇文章。

基础设施层的技能栈主要是:运维、网络建设,我们不在本书中做更多讨论。

-

运维平台层

运维平台层是“持续交付”的重要载体,包括:

持续部署系统:构建从代码仓库、持续集成、持续部署的全链路系统、最终实现持续交付。

部署的版本管理系统:管理部署镜像粒度的版本,以支持滚动发布、回滚等部署功能。

容器、容器管理调度平台:容器是一种操作系统级的轻量虚拟化技术。在部署系统中,不仅需要容器技术、还需要容器调度管理系统。这两项技术我们会在后续章节展开讨论。

-

微服务设施层

本层为微服务的开发和运行提供公用的设施基础。

在这里我们只做基本介绍,在后续章节会详细展开。

开发框架:微服务的开发需要一些基础的编程框架,可以自己从零搭建,也可以基于成熟开源框架完善。

RPC:微服务内部使用RPC(Remote Procedure Call)完成通信。

服务注册与发现:微服务A调用服务B且后者有3个实例,如何感知这3个实例的IP、端口,以及A要调用哪个实例呢?这就是服务的注册与发现问题,是微服务的核心问题之一。

配置中心:微服务的数量、实例众多,逐一修改配置文件的传统模式,既不经济又容易出错。配置中心是一个中央(但不一定是单机)配置系统,负责配置管理、修改等工作。

熔断:当微服务调链路上,服务不可用或响应时间太长时,触发熔断,快速提前返回。举个例子:家里有用电设备路时电流过大,空气开关会直接跳闸,防止造成进一步的破坏。

限流:为了保护服务不被流量击垮,而提前限制流量。举个例子:经过测算,故宫接待能力是每日1万人。那么当天超过1万后,就触发限流,不让更多游客入园。

数据库:传统的SQL数据库用于业务数据落盘,NoSQL数据库则用于缓存或高性能存取。

消息队列:将业务流量“削峰填谷”,对应对突发流量。

中间件:中间件是介于 服务端 与 数据库、消息队列等设施的中间。中间件帮助 业务服务更简单地使用这些基础设施。

近几年,“可观测性”成为了新的技术热词。这个舶来于控制理论的词,在软件系统中指的是:可以帮团队有效调试系统的工具或解决方案。以这个视角看,下述部分都是可观测性的一部分:

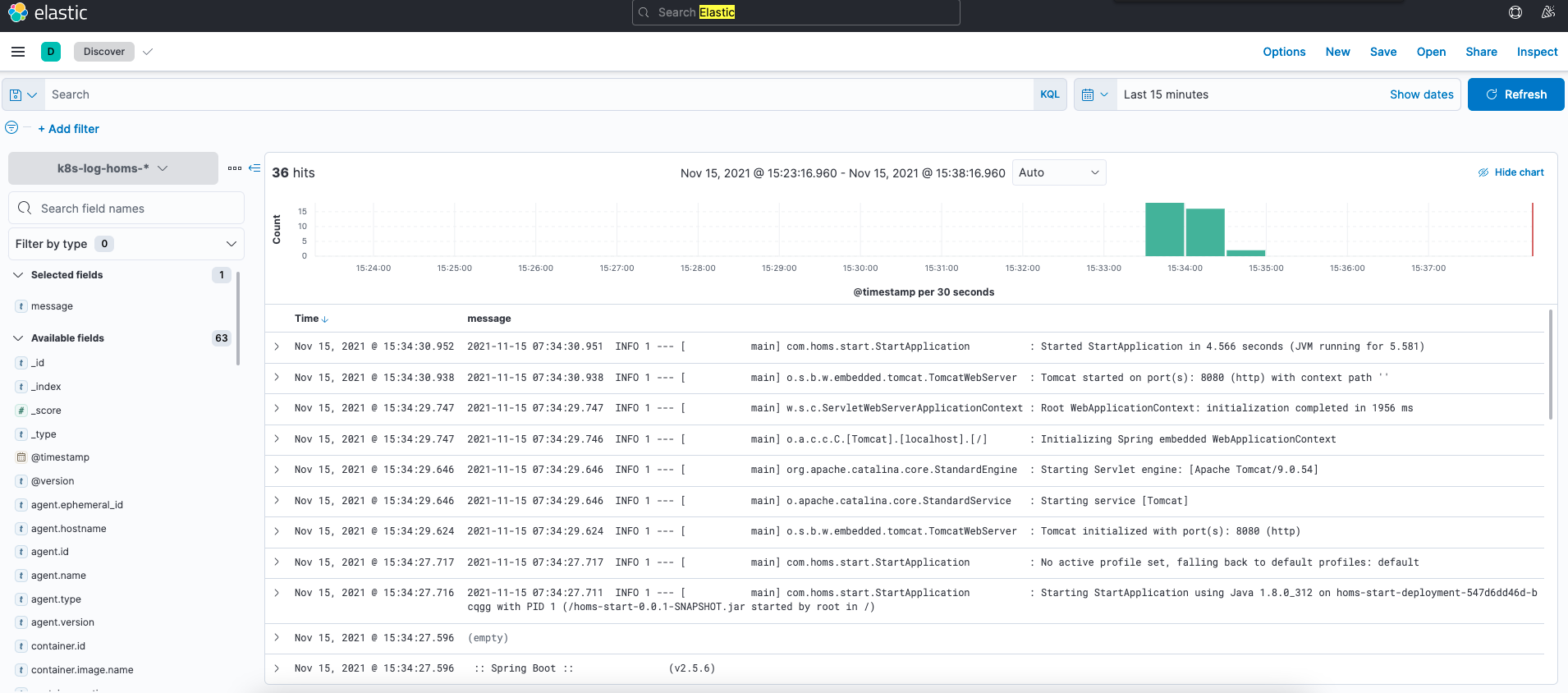

日志:如何在众多的微服务实例中,快速定位到某一种出错日志?日志平台实现了微服务实例中的日志收集、存储、检索、分析。

监控系统:通过采集多种指标,实时反馈系统运行状态,保证服务的平稳运行。举个生活中的例子:汽车驾驶位的仪表盘。

报警系统:当监控系统发现异常时,及时将报警发送出来。

链路追踪:当服务A->B->C调用链上发生超时,如何快速定位哪个环节发生了故障?链路追踪解决了分布式、复杂调用链路中的采集、追踪,分析工作。

-

业务服务层

借助“基础设施“、”运维平台“、”微服务设施“的帮助,我们可以更高效、稳健的应用微服务,实现业务目标。关于微服务的拆分、建模理论,可以参考“领域驱动设计”的相关内容,本书不做讨论。

-

聚合接入层

在“微服务概述”一节中,我们曾提到微服务的缺点之一:拆分导致的复杂度升高。在当前主流的前后端分离架构中,用户对这一拆分基本无感知。复杂度被转嫁到 前端 / 客户端 中:原本只需要调用一个接口,现在要分别调用N个微服务。还需要考虑时序关系、错误处理等。聚合接入层就是为解决这个问题而生的,他聚合多个微服务的调用,只保留必要字段,为前端 / 客户端提供了统一、清晰的服务接口。聚合接入层可以由服务端实现,有时还会加入部分熔断、限流等逻辑,组合成为微服务网关。聚合接入也可以由前端实现,有时也被称作BFF(Backend For Frontend)。

在剖析微服务的各层架构之后,不难发现:微服务的架构下,需要多个团队,多层系统、多纬度的支持。这也印证了在“微服务概述”一节中的观点:应用微服务架构,需要较高成本。

因此,尽量选用成熟、易维护的技术,从而尽可能降低成本,显得尤为重要。我们将在下一节展开讨论技术选型。

一种微服务分层架构的技术栈选型

我们在工具链、一种微服务的分层架构 两小节中讨论了技术栈的需求。

在本节中,我们将具体讨论技术栈的选型。

你可能注意到,上一节的标题是“一种微服务的分层架构”,而这一节的标题是“一种微服务分层架构的技术栈选型”。

加上“一种”这个词是有意而为之,请不要怀疑我的语文水平:-)

"一种"强调的是:

-

微服务只是一种架构风格,他可以有N种不同的实现,上一节只介绍了其中一种。

-

每一种微服务架构的实现,也可以对应N种不同的技术栈选型。

那么,在这N^2种架构 + 技术栈的组合种,哪一种才是最好的?

不急着回答,我们先来看下这个:

php is the best language for web programming.

这是PHP官方手册的原文,更多人更熟悉前5个单词,“PHP是全世界最好的语言”。

但加上后3个单词“for web programming”后,就变成了“PHP是web领域最好的语言”。

而我的观点(哪个架构更优) 与 PHP社区(关于语言优劣)的观点,是一致的:没有最好的语言(技术),只有最适合具体场景的。

因此,我们只会针对各项场景,列出技术选型,而不会打“为什么A比B好的”口水战。

容器管理平台的技术选型

微服务架构下会对服务进行拆分,产生大量的服务实例。

容器化技术,可以实现环境隔离、快速部署,是微服务架构的基石。

Docker凭借“快速”、“可移植性”等特性""一战成名",是单机或小规模应用部署的最佳选择

然而,在复杂的分布式部署场景中,"扩容"、"编排"、"故障恢复"等成为了"刚需",“容器管理平台”应运而生。在这个赛道上,曾经出现过三个主流产品:

-

swarm: Docker公司于2014年末推出的容器集群技术方案。尽管swarm是Docker公司的“亲儿子”、手握大量社区资源,但很快被Kubernetes超越。

-

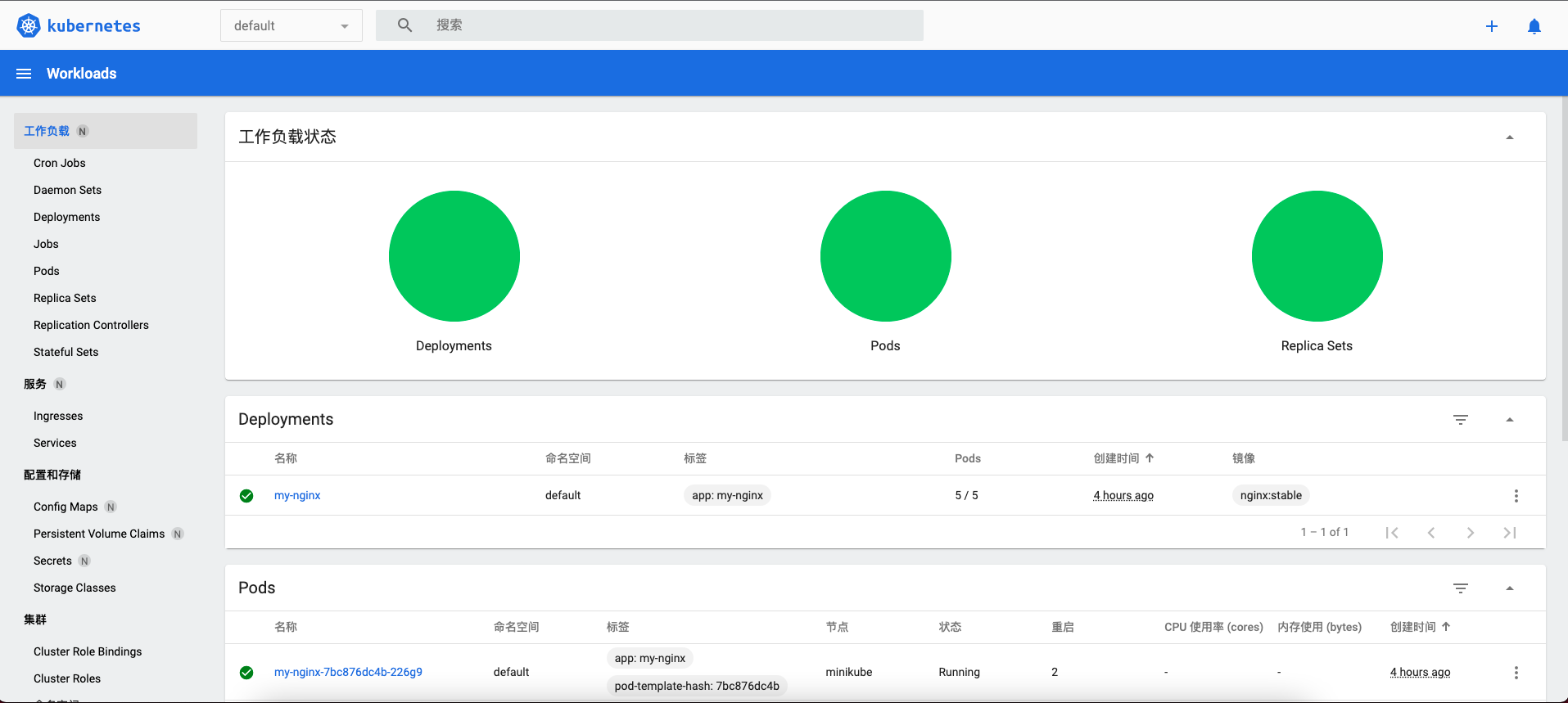

Kubernetes: 简称k8s,支持自动部署,扩展和管理容器化应用程序的开源系统。k8s借鉴了Google的Borg管理系统,自问世以来发展迅猛,当前已经成为了容器管理的事实标准。

-

Marathon: 构建在[Apache Mesos](Apache Mesos)集群上的一套容器集群管理软件。由于Mesos的部署存在门槛,Marathon项目的关注度并不高,社区也并不活跃。其上一个发布版本依然停留在2019年,已经近2年没有更新。

因此,我们"毫无争议"地选择k8s作为微服务架构下的容器管理平台。

除了容器管理平台,我们还需要镜像仓库存储应用的容器镜像,我们将使用Docker搭建私有镜像仓库。

微服务设施层的技术选型

设施层涉及较多的技术需求,技术选型如下:

| 需求 | 选型 | 版本 |

|---|---|---|

| 开发语言 | Java | 8 |

| 开发框架 | Spring Boot | 2.5.4 |

| RPC | gRPC | 1.14.x |

| 服务注册 / 发现 / 配置中心 | Nacos | 2.x |

| 熔断 / 限流 | Resilience4j | 1.7.1 |

| SQL数据库 | MySQL | 8.0.X |

| 内存数据库 | Redis | 6.2 |

| 消息队列 | RocketMQ | 4.9.1 |

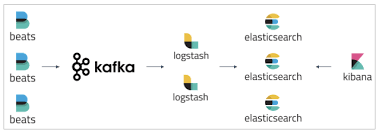

| 日志 | Kafka + ELK | 2.13 + 7.14.X |

| 监控 / 告警 | VictoriaMetrics + Grafana | 1.64.1 + 8.1.X |

| 链路追踪 | SkyWalking | 8.7.0 |

开发语言:我们选择了Java做为开发语言。与新近崛起的Go、Rust等语言相比,Java不是最完美的语言,但它依然拥有较高的开发、运行效率,最充足的人才供给。版本方面我们选择Java 8(最后一个免费的Java版本)。

开发框架:在Java开发领域,Spring生态的渗透率已超过60% ([出处](Spring dominates the Java ecosystem with 60% using it for their main applications | Snyk))。顺应这一趋势,我们选择Spring 生态内的Spring Boot做为主要开发框架。Spring Boot提供的注解配置、嵌入式容器、starter等特性,可以极大简化Java应用的开发。

RPC框架:我们选择开源的gRPC做为RPC框架,它使用Protocl Buffer序列化,HTTP 2传输协议,具有更灵活的通信模式和较高的传输效率。

服务注册、发现、配置中心:[Nacos](什么是 Nacos)是阿里巴巴开源的服务管理项目,同时具备服务注册、发现、配置中心。Nacos原生支持Spring Boot、k8s等融合方向。经过几年的发展,Nacos已经较为成熟,支撑了阿里巴巴、中国移动等数十家大型公司的线上系统。

熔断、限流:本书不会探讨Service Mesh等平台级别的流量控制方案。我们主要讨论服务进程级别的熔断、限流方案。老牌项目Hystrix停更后,我们选择开源的Resilience4j做为熔断、限流的Java库解决方案。

数据库:做为开源数据库的佼佼者,MySQL常年稳居市场份额的前三名。我们选择其较新的稳定版8.0.X。

内存数据库:做为SQL数据库的补充,内存数据库的应用场景是:吞吐量更大、延迟更低。高性能的Redis是最佳选择。根据官方评测,Redis 6.x在开启pipeline模式的前提下,可以提供高达55万RPS。

消息队列:Apache RocketMQ是阿里巴巴的开源的分布式消息队列,具有极低的延迟和较高的吞吐量。相比于老牌的Kafka,Rocket MQ更适用于消息队列的场景。我们选用其最新稳定版4.9.1。

日志:ELK是经典的日志日志方案。在此基础上,我们前置增加了Kafka,利用其强大的写能力,构建起缓冲队列,以应对海量日志的突发写入。

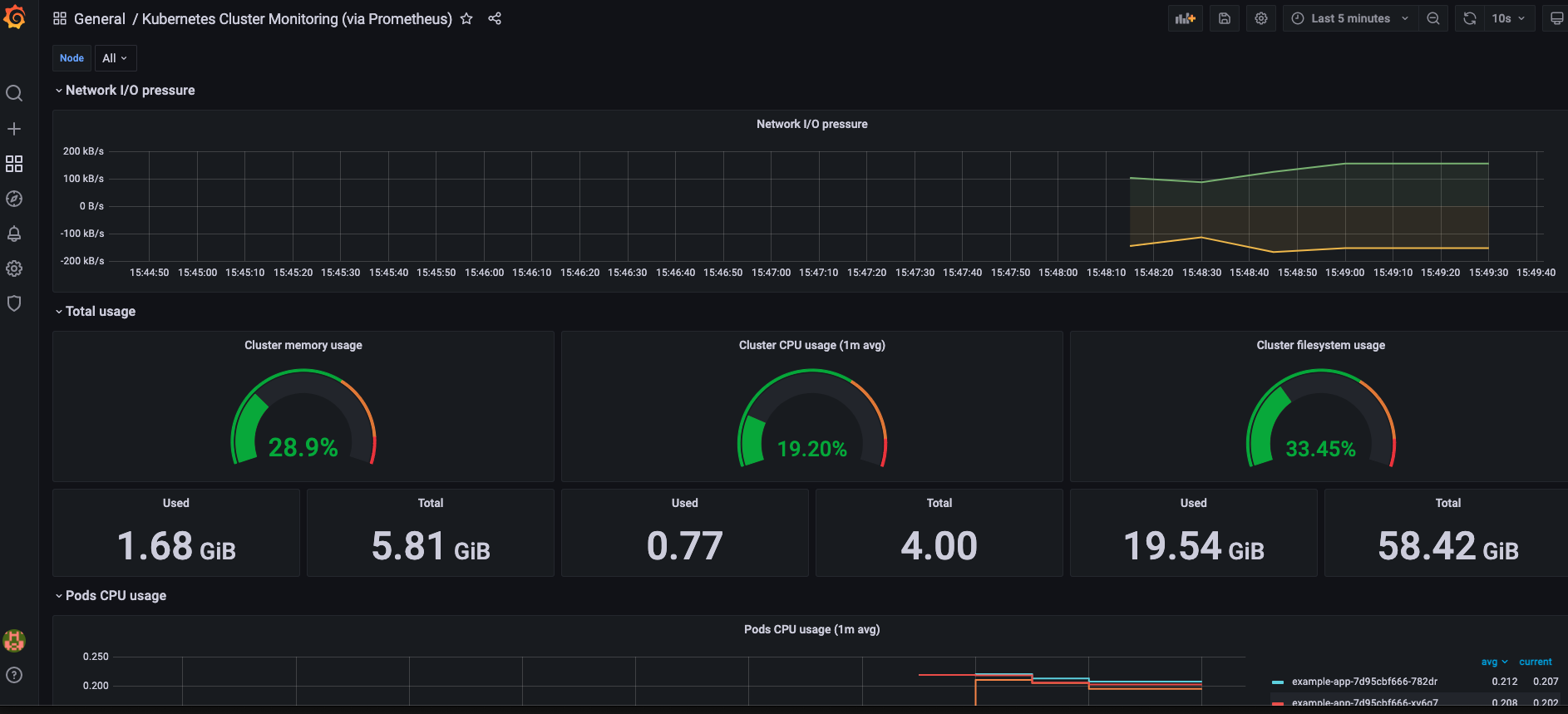

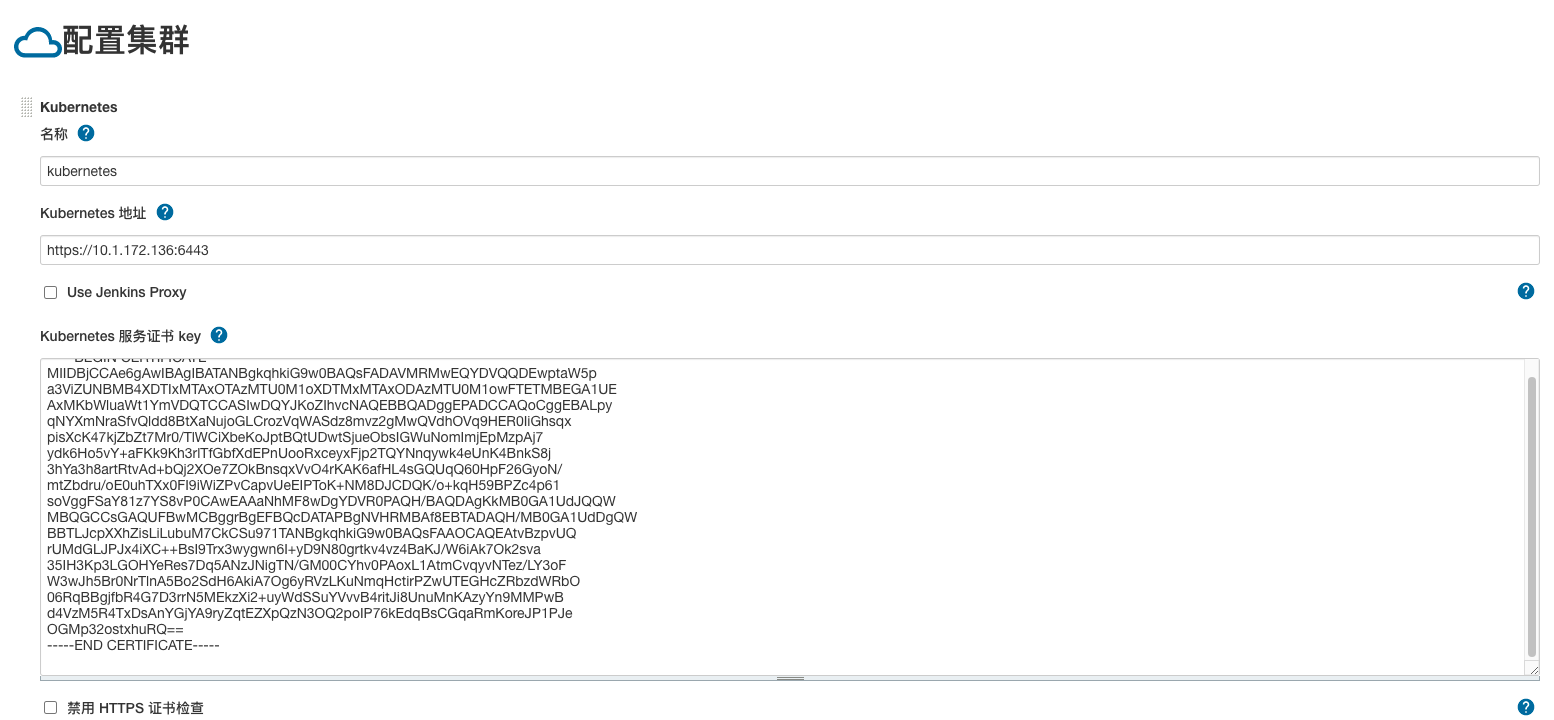

监控 / 告警:纵观DevOps领域,Prometheus + Grafana已经成为了监控领域的事实标准。然而,Prometheus并不支持原生的集群部署,其在大规模应用下很容易出现瓶颈。VictoriaMetrics是一款可以嵌入Prometheus的分布式时序存储引擎。起初VictoriaMetrics只想做一个引擎,在近几个版本社区加大了对vmagent的开发投入。vmagent是一款轻量级的代理,兼容Prometheus协议,可以直接替代Prometheus完成大部分工作。在本书中,我们直接选择VictoriaMetrics + Grafana做为兼容告警的默认技术栈。

链路追踪:SkyWalking是由国人主导的一款开源APM(application performance management)。在小米、滴滴等公司都有应用。我们选择其最新的稳定版本。

看了上面的文字,你可能有点困惑:“只是简单罗列选型结果,并没有具体分析过程“?

技术选型是一个非常大的话题,每一个点单独拎出来,都能洋洋洒洒的写一章出来,但是我觉得必要性不大,原因在于:

-

技术演进的速度非常快,今天适合的明天就有可能被淘汰(看看Docker)

-

每个公司面临的具体场景情况都是不同的,很难穷尽、更无法全部都满足

因此,我只是在自己可见的技术水平内,选择了相对靠谱的方案,解决了一部分“选择障碍的问题”,如果你有更优秀的选择,也欢迎提Issue交流、讨论。

微服务开发上篇:开发框架及其与RPC、数据库、Redis的集成

从这一章开始,我们正式进入微服务开发篇,共分上、中、下三篇。

本章我们将讨论开发框架,框架与RPC、数据库、Redis的集成。

2001年,我刚开始编程时,接触的第一个语言是"ASP"(没有.net),它通过脚本注解的方式,实现动态功能(存取数据库等),有点类似于PHP。在那个没有开发框架的年代,我们依然可以实现功能。但是这里只是“功能上的满足”,确无法做到“工程上的最优”,例如:

-

HTML与脚本混编,无论是页面样式修改,还是逻辑修改都很麻烦(视图、逻辑混合)

-

有不少功能重复的代码,无法复用(如创建数据库连接)

-

页面之间的内部依赖难以处理(往往只能通过url / session参数传递)

开发框架的出现,解决了上述部分问题,以Spring为例:

-

Spring MVC实现的分层架构,将页面、视图、逻辑层强制分离

-

Spring JPA组件可以创建数据库模板,减少重复代码

-

通过IoC容器,可以清晰地分离逻辑、处理依赖

-

....

当然,引入开发框架会带来额外的学习成本。Spring Boot借鉴了ROR框架中“约定优于配置”的设计理念,进行了大量的改造,实现了框架的“开箱可用”,有效降低了学习成本。

本章会使用一个微服务为例,介绍Gradle + Spring Boot的基础集成。在此基础上,我们会介绍几个与框架紧密相关的内容:RPC框架、数据库、Redis的集成。

Gradle构建工具配置

构建工具解决了依赖管理、打包流程、项目结构工程化等问题,是现代软件开发中的必备工具。

Gradle是一款Java开发语言的构建工具,兼容POM以来,使用Groovy作为描述语言,构建速度快、可拓展性强,是大量项目的首选。

在本节中,我们将介绍Gradle的基本用法与配置。

Gradle的下载与安装

我们使用稳定版7.2,你可以在官网下载二进制版本。

解压缩后,需要将二进制目录加入你的PATH路径:

export PATH=$PATH:HOME/soft/gradle/bin/

然后执行gradle,查看是否安装成功

gradle -v

------------------------------------------------------------

Gradle 7.2

------------------------------------------------------------

Build time: 2021-08-17 09:59:03 UTC

Revision: a773786b58bb28710e3dc96c4d1a7063628952ad

Kotlin: 1.5.21

Groovy: 3.0.8

Ant: Apache Ant(TM) version 1.10.9 compiled on September 27 2020

JVM: 1.8.0_291 (Oracle Corporation 25.291-b10)

OS: Mac OS X 10.16 x86_64

修改Gradle的Maven仓库镜像

gradle的依赖使用了Maven的仓库。由于众所周知的原因,这些仓库在国内的速度并不稳定,我们需要将仓库切换成国内镜像。

修改~/.gradle/init.gradle文件如下:

// project

allprojects{

repositories {

mavenLocal()

maven { url 'https://maven.aliyun.com/repository/public/' }

maven { url 'https://maven.aliyun.com/repository/jcenter/' }

maven { url 'https://maven.aliyun.com/repository/google/' }

maven { url 'https://maven.aliyun.com/repository/gradle-plugin/' }

maven { url 'https://jitpack.io/' }

}

}

// plugin

settingsEvaluated { settings ->

settings.pluginManagement {

// Clear repositories collection

repositories.clear()

// Add my Artifactory mirror

repositories {

mavenLocal()

maven {

url "https://maven.aliyun.com/repository/gradle-plugin/"

}

}

}

}

解释下文件配置:

-

上半部分:将maven中央仓库、jcenter仓库都修改为国内镜像(阿里云),并增加了jitpack仓库(后续章节会使用)。

-

下半部分:将gradle插件仓库修改为国内镜像,这部分是必须的,不要忘记。

我们可以通过一个简单的脚本,检查配置是否生效

验证脚本build.gradle

task listrepos {

doLast {

println "Repositories:"

project.repositories.each { println "Name: " + it.name + "; url: " + it.url }

}

}

执行验证:

gradle listrepos

Repositories:

Name: MavenLocal; url: file:/Users/coder4/.m2/repository/

Name: maven; url: https://maven.aliyun.com/repository/public/

Name: maven2; url: https://maven.aliyun.com/repository/jcenter/

Name: maven3; url: https://maven.aliyun.com/repository/google/

Name: maven4; url: https://maven.aliyun.com/repository/gradle-plugin/

Name: maven5; url: https://jitpack.io/

IntelliJ

gradle-wrapper生成

gradle-wrapper是用于执行gradle的脚本 + 精简版的gradle二进制文件。

既然已经有了gradle,为什么还要单独弄一个wrapper出来么?

-

方便没有安装gradle的环境执行构建(例如打包机)

-

支持多版本gradle的快速切换(实现nvm的效果)

初始化gradle项目时,执行如下命令:

gradle init

gradle会生成如下wrapper相关文件:

├── gradle

│ └── wrapper

│ ├── gradle-wrapper.jar

│ └── gradle-wrapper.properties

├── gradlew

├── gradlew.bat

└── settings.gradle

建议将上述文件一并加入git仓库中,以防出现版本兼容问题。

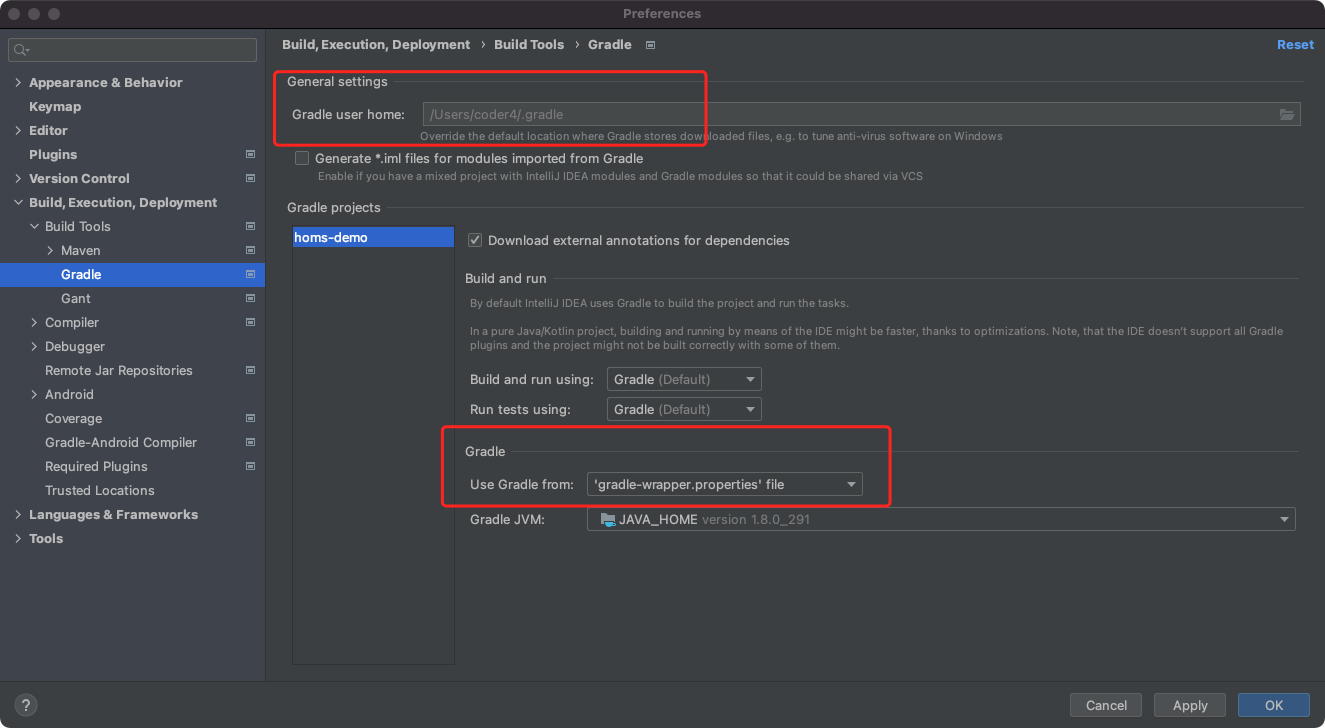

IntelliJ IDEA中配置Gradle

IntelliJ IDEA是一款功能强大的IDE,是许多Java程序员的首选。

IDEA默认支持Gradle,请确保配置正确:

上方的Gradle配置文件默认路径,请维持默认配置,使用家目录下默认的。

下方的Gradle版本,推荐使用默认选项(gradle-wrapper.properties),即使用项目路径下gradle-wrapper.properties指定的版本。

经过上述配置,我们已经搭建了Gradle的构建环境。在下一节,我们会在此基础上集成Spring Boot框架。

Sprint Boot项目与Gradle的集成

本节我们将借助Spring Start快速搭建微服务项目。

在此基础上,我们会将工程改造成子项目的组织形式。

Spring Start快速生成项目

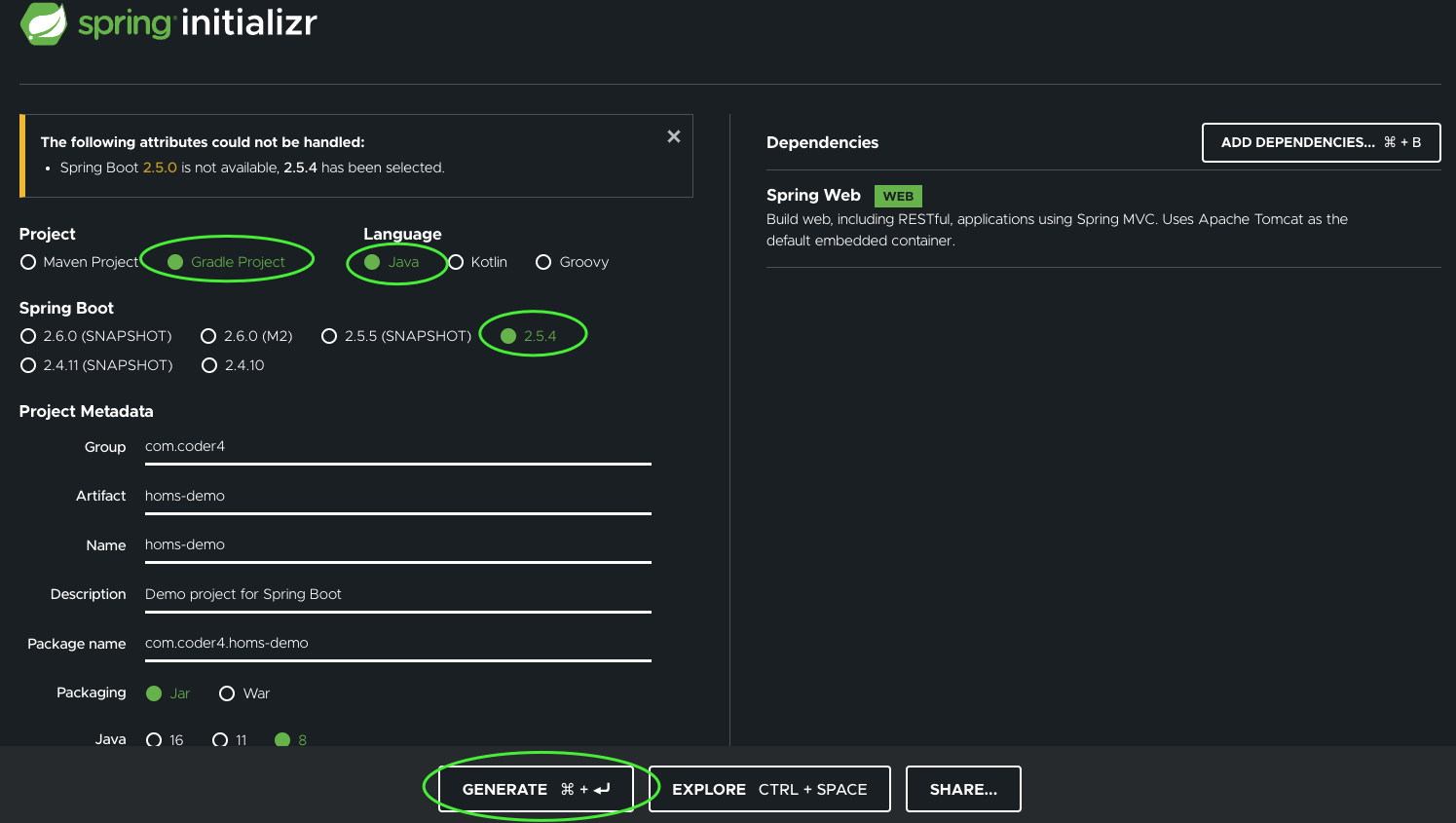

为了降低微服务的开发门槛,社区提供了Spring initializr工具。它可以一键生成微服务项目。如图所示:

我们需要注意几个配置:

-

Project(项目):选择Gradle

-

Language(开发语言):选择Java

-

Spring Boot(版本):选择2.5.4

-

下面的工程名、包名根据自己的需要填写

-

Java(版本):选择8

完成后,点击下方的GENERATE(生成)按钮,即可下载项目的zip包。

解压缩后,目录结构如下:

.

├── HELP.md

├── build.gradle

├── gradle

│ └── wrapper

│ ├── gradle-wrapper.jar

│ └── gradle-wrapper.properties

├── gradlew

├── gradlew.bat

├── settings.gradle

└── src

├── main

│ ├── java

│ │ └── com

│ │ └── coder4

│ │ └── homsdemo

│ │ └── HomsDemoApplication.java

│ └── resources

│ ├── application.properties

│ ├── static

│ └── templates

└── test

└── java

└── com

└── coder4

└── homsdemo

└── HomsDemoApplicationTests.java

这是一个标准的gradle项目路径:

- gradle*:gradle相关文件,可以参考Gradle构建工具配置一节中的介绍

- src:项目源文件

- test:项目单元测试文件

我们来看一下src目录下唯一的Java源文件,HomsDemoApplication.java:

package com.coder4.homsdemo;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

@SpringBootApplication

public class HomsDemoApplication {

public static void main(String[] args) {

SpringApplication.run(HomsDemoApplication.class, args);

}

}

借助Spring Boot的精简设计,项目只需上述一个源文件即可服务端进程

编译项目:

gradle build

BUILD SUCCESSFUL in 19s

7 actionable tasks: 7 executed

运行项目:

java -jar ./build/libs/homs-demo-0.0.1-SNAPSHOT.jar

. ____ _ __ _ _

/\\ / ___'_ __ _ _(_)_ __ __ _ \ \ \ \

( ( )\___ | '_ | '_| | '_ \/ _` | \ \ \ \

\\/ ___)| |_)| | | | | || (_| | ) ) ) )

' |____| .__|_| |_|_| |_\__, | / / / /

=========|_|==============|___/=/_/_/_/

:: Spring Boot :: (v2.5.4)

2021-09-08 12:47:51.906 INFO 2806 --- [ main] com.coder4.homsdemo.HomsDemoApplication : Starting HomsDemoApplication using Java 1.8.0_291 on coder4deMacBook-Pro.local with PID 2806 (/Users/coder4/Downloads/homs-demo/build/libs/homs-demo-0.0.1-SNAPSHOT.jar started by coder4 in /Users/coder4/Downloads/homs-demo)

2021-09-08 12:47:51.909 INFO 2806 --- [ main] com.coder4.homsdemo.HomsDemoApplication : No active profile set, falling back to default profiles: default

2021-09-08 12:47:52.960 INFO 2806 --- [ main] o.s.b.w.embedded.tomcat.TomcatWebServer : Tomcat initialized with port(s): 8080 (http)

2021-09-08 12:47:52.975 INFO 2806 --- [ main] o.apache.catalina.core.StandardService : Starting service [Tomcat]

2021-09-08 12:47:52.975 INFO 2806 --- [ main] org.apache.catalina.core.StandardEngine : Starting Servlet engine: [Apache Tomcat/9.0.52]

2021-09-08 12:47:53.032 INFO 2806 --- [ main] o.a.c.c.C.[Tomcat].[localhost].[/] : Initializing Spring embedded WebApplicationContext

2021-09-08 12:47:53.032 INFO 2806 --- [ main] w.s.c.ServletWebServerApplicationContext : Root WebApplicationContext: initialization completed in 1067 ms

2021-09-08 12:47:53.413 INFO 2806 --- [ main] o.s.b.w.embedded.tomcat.TomcatWebServer : Tomcat started on port(s): 8080 (http) with context path ''

2021-09-08 12:47:53.424 INFO 2806 --- [ main] com.coder4.homsdemo.HomsDemoApplication : Started HomsDemoApplication in 1.951 seconds (JVM running for 2.388)

我们在浏览器打开 http:127.0.0.1:8080 已经可以成功打开了!

在微服务架构中,需要新建大量微服务。而Spring社区提供的Starter工具,降低了微服务的初始化门槛。在实际开发中,我们也可以结合实际情况,定制出适合自己团队的脚手架工具。

子项目改造

上述脚手架生成的项目,是独立项目模式:一个目录下,只有一个独立项目。

在实际微服务开发中,一个目录下需要多组相互关联的子项目,例如:

-

protobuf和桩文件单独拆成子项目

-

常量提取到单独子项目

在本书的实战中,我们的微服务选用的是server / client 双子项目结构

-

client:内置protobuf、桩文件,客户端代码、自动配置代码

-

server:专注服务端逻辑开发

将Gradle项目拆分为子项目的功能,网上资料不多,自己摸索需要踩很多坑。

本文提供的也只是一种实现方式,你可以在此基础上,进行改造。

先看下整体目录结构:

./├── build.gradle

├── gradle

│ └── wrapper

│ ├── gradle-wrapper.jar

│ └── gradle-wrapper.properties

├── gradlew

├── gradlew.bat

├── homs-demo-client

│ ├── build.gradle

│ └── src

│ └── main

│ └── java

│ └── com

│ └── coder4

│ └── homs

│ └── demo

│ ├── HomsDemo.proto

│ ├── HomsDemoGrpc.java

│ ├── HomsDemoProto.java

│ └── client

│ └── HomsDemoClient.java

├── homs-demo-server

│ ├── build.gradle

│ └── src

│ ├── main

│ │ ├── java

│ │ │ └── com

│ │ │ └── coder4

│ │ │ └── homs

│ │ │ └── demo

│ │ │ └── server

│ │ │ ├── Application.java

│ │ └── resources

│ │ └── application.yaml

│ └── test

│ └── java

│ └── com

│ └── coder4

│ └── homs

│ └── demo

│ └── server

│ └── Test.java

└── settings.gradle

如上图所述,我们在独立项目的基础上,改造如下:

-

新增homs-demo-client / homs-demo-server 两个子项目

-

子项目内,额外添加了build.gradle文件

下面我们来看下gradle的相关配置

首先是根目录下的

settings.gradle

rootProject.name = 'homs-demo'

include 'homs-demo-client'

include 'homs-demo-server'

如上所述,定义了项目名为"homs-demo",两个子项目"homs-demo-client" 和 "homs-demo-server"。

接着看一下根目录下的

build.gradle

plugins {

id 'java'

id 'idea'

id 'org.springframework.boot' version '2.5.3' apply false

id 'io.spring.dependency-management' version '1.0.11.RELEASE' apply false

}

subprojects {

group = 'com.coder4'

version = '0.0.1-SNAPSHOT'

sourceCompatibility = '1.8'

}

这里的plugin部分,定义了4个插件:

-

java:java项目必选

-

idea (Intellj IDEA):生成idea需要的文件

-

org.springframework.boot:Spring Boot插件,支持构建可执行的server.jar

-

io.spring.dependency-management:Spring Boot相关版本的依赖管理

subprojects部分定义了所以子项目(server / client)的公用参数

-

group / version 项目包名和版本

-

sourceCompatibility:Java 8的语言版本

我们再来看一下client子项目

homs-demo-client/build.gradle

plugins {

id 'java'

id 'io.spring.dependency-management'

}

dependencies {

implementation "org.slf4j:slf4j-api:1.7.32"

}

上述是client子项目的gradle配置,不难发现:

-

plugins:java、spring依赖

-

dependencies:这里的配置等同于maven的pom.xml中的依赖配置,但gradle以冒号分割的语法更加简洁。这里只配置了一个slf4j。

再看下server子项目

plugins {

id 'java'

id 'org.springframework.boot'

id 'io.spring.dependency-management'

}

dependencies {

implementation project(':homs-demo-client')

implementation 'org.slf4j:slf4j-api:1.7.32'

implementation 'org.springframework.boot:spring-boot-starter-web'

}

server与client有所不同:

-

plugins:增加了spring boot插件

-

dependencies:首先依赖了客户端子项目,接着依赖Spring Boot的web-starter。

你可能已经注意到了,在server的依赖中,并没有设定spring-boot-starter-web的版本。

Spring相关依赖的版本补全由'dependency-management'插件自动处理。当我们在项目根路径的build.gradle中,声明Spring Boot插件和Dependency Management时,就确定了所有子项目中,Spring依赖的版本。

经过上述改造,我们已经“基本”完成了子项目的改造。

实现BOM功能

为什么我们说“基本”完成呢?

因为,子项目改造引入了新的问题:

若在client和server中,各自依赖slf4j但版本不同,会发生什么情况?

没错,这就是经典的“Maven依赖冲突”问题,关于背景和常见解法可以参考[这篇](Solving Dependency Conflicts in Maven - DZone Java)文章。

依赖冲突问题的最根本解法是:让大家都依赖于相同的版本。在Maven中可以使用bom清单(bill of material):将所有公用包的版本都声明在bom文件中,然后其余项目都依赖bom。

Gradle并没有直接实现BOM,但在6.0+支持了platform机制。它可以实现与BOM类似的效果。

我们新建一个独立的项目,bom-homs

settings.gradle

rootProject.name = 'bom-homs'

这里声明了bom的名字

build.gradle

plugins {

id 'java-platform'

id 'maven-publish'

}

group 'com.coder4'

version '1.0'

dependencies {

constraints {

api 'org.slf4j:slf4j-api:1.7.32'

}

}

publishing {

publications {

myPlatform(MavenPublication) {

from components.javaPlatform

}

}

}

上述配置的解析如下:

-

plugins:platform和maven发布插件

-

group、version:maven中同等概念,一会用到

-

dependencies:公用包的版本声明,这里只又一个slf4j

-

publishing:这里借用了Maven的发布方式

下面我们执行发布(到本地):

gradle publishToMavenLocal

BUILD SUCCESSFUL in 704ms

3 actionable tasks: 3 executed

(这里我们暂时发布到本地,如何发布到远程、私有仓库,将在后续章节再介绍。)

成功发布后,我们回到homs-demo项目中,将server的子项目改造如下:

plugins {

id 'java'

id 'org.springframework.boot'

id 'io.spring.dependency-management'

}

dependencies {

implementation project(':homs-demo-client')

implementation platform('com.coder4:bom-homs:1.0')

implementation 'org.slf4j:slf4j-api'

implementation 'org.springframework.boot:spring-boot-starter-web'

}

通过引入platform,我们就无需在项目中指明slf4j的版本了,从而在源头上解决了版本冲突的问题!

针对client子项目,也是类似的修改,这里不做赘述。

至此,我们完成Gradle与Spring Boot的集成、子项目拆分。

关于“Spring Boot + Gradle子项目”的资料,在网上并不多见,希望你能仔细阅读、反复揣摩、举一反三:-)

本文涉及的项目代码,我整理到了这里,供大家参考。

Spring Boot集成SQL数据库1

从银行的交易数据到打车订单,衣食住行,都离不开数据库的存储。

在接下来的两个小节中,我们将通过3种不同的技术,在Spring Boot中集成MySQL数据库。

-

JDBC

-

MyBatis

-

JPA (Hibernate)

本节的前半部分,我们将通过Docker快速搭建MySQL的环境,随后介绍JDBC的集成方式。

搭建MySQL实验环境

本书的重点是讨论微服务实战,我们直接使用Docker的方式,快速搭建实验环境。

如果你想部署在生产环境,请参考官方部署文档。

首先,请确认已经成功安装了Docker:

docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

若尚未安装Docker,可以参考[官方文档](Install Docker Engine | Docker Documentation)。

MySQL的Docker运行脚本如下:

#!/bin/bash

NAME="mysql"

PUID="1000"

PGID="1000"

VOLUME="$HOME/docker_data/mysql"

MYSQL_ROOT_PASS="123456"

mkdir -p $VOLUME

docker ps -q -a --filter "name=$NAME" | xargs -I {} docker rm -f {}

docker run \

--hostname $NAME \

--name $NAME \

--volume "$VOLUME":/var/lib/mysql \

--env MYSQL_ROOT_PASSWORD=$MYSQL_ROOT_PASS \

--env PUID=$PUID \

--env PGID=$PGID \

-p 3306:3306 \

--detach \

--restart always \

mysql:8.0

如脚本所述:

-

使用官方的8.0镜像启动Docker

-

退出后自动重启

-

暴露3306端口到本机

-

设置Volume盘到~/docker_data/mysql路径下

-

root密码123456(请务必更改为安全密码)

执行后的效果:

docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

feb2838197a6 mysql:8.0 "docker-entrypoint.s…" 46 hours ago Up 7 hours 0.0.0.0:3306->3306/tcp, :::3306->3306/tcp, 33060/tcp mysql

启动成功后,我们尝试连接数据库,新建库并授权给用户:

mysql -h 127.0.0.1 -u root -p

> CREATE DATABASE homs_demo;

> CREATE USER 'HomsDemo'@'%' identified by '123456';

> GRANT ALL PRIVILEGES ON homs_demo.* TO 'HomsDemo'@'%';

尝试用新用户登录:

mysql -h 127.0.0.1 -u HomsDemo -p homs_demo

若能成功登录,我们创建本书实验所需的表:

CREATE TABLE `users` (

`id` bigint NOT NULL AUTO_INCREMENT,

`name` varchar(64) NOT NULL,

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;

这里我们创建了表users,有两个列:id和name。

温馨提示:我们使用utf8mb4字符集,如果用utf8是会有坑,可以参考这篇文章。强烈推荐你对所有的数据表,都设置为utf8mb4。

Spring Boot 集成 JDBC操作MySQL

我们先通过集成jdbc的方式操作MySQL数据库。

首先在server项目的build.gradle中添加依赖

implementation 'org.springframework.boot:spring-boot-starter-jdbc'

implementation 'mysql:mysql-connector-java:8.0.20'

上述依赖中:

-

spring-boot-starter-jdbc是集成jdbc的starter依赖包

-

mysql-connector-java是集成MySQL的驱动

接着,我们配置下数据源:

spring.datasource:

url: jdbc:mysql://127.0.0.1:3306/homs_demo?useUnicode=true&characterEncoding=UTF-8&useSSL=false

username: HomsDemo

password: 123456

hikari:

minimumIdle: 10

maximumPoolSize: 100

上述配置分为两部分:

-

spring.datasource.url / username / password定义了MySQL的访问链接

-

hikari是数据库连接池的配置。

Hikari是Spring Boot 2默认的链接池,官方性能评测优秀。这里我们配置了minimumIdle(最小连接数)和maximumPoolSize(最大连接数)两个选项。更多配置参数可以参考[官方文档](GitHub - brettwooldridge/HikariCP: 光 HikariCP・A solid, high-performance, JDBC connection pool at last.)。

经过上述的组合配置后,对应DataSource对应的Configuration会自动激活,并注册一系列的关联Bean。

下面让我们使用它访问MySQL数据库:

@Repository

public class UserRepository1Impl implements UserRepository {

@Autowired

protected NamedParameterJdbcTemplate db;

private static RowMapper<User> ROW_MAPPER = new BeanPropertyRowMapper<>(User.class);

@Override

public Optional<Long> create(User user) {

String sql = "INSERT INTO `users`(`name`) VALUES(:name)";

SqlParameterSource param = new MapSqlParameterSource("name", user.getName());

KeyHolder holder = new GeneratedKeyHolder();

if (db.update(sql, param, holder) > 0) {

return Optional.ofNullable(holder.getKey().longValue());

} else {

return Optional.empty();

}

}

@Override

public Optional<User> getUser(long id) {

String sql = "SELECT * FROM `users` WHERE `id` = :id";

SqlParameterSource param = new MapSqlParameterSource("id", id);

try {

return Optional.ofNullable(db.queryForObject(sql, param, ROW_MAPPER));

} catch (EmptyResultDataAccessException e) {

return Optional.empty();

}

}

@Override

public Optional<User> getUserByName(String name) {

String sql = "SELECT * FROM `users` WHERE `name` = :name";

SqlParameterSource param = new MapSqlParameterSource("name", name);

try {

return Optional.ofNullable(db.queryForObject(sql, param, ROW_MAPPER));

} catch (EmptyResultDataAccessException e) {

return Optional.empty();

}

}

}

在上面的代码中,我们自动装配了"NamedParameterJdbcTemplate",然后用它访问MySQL数据库:

-

读请求使用db.query,配合RowMapper做类型转化

-

写请求使用db.update,配合KeyHolder获取自增主键

使用JDBC访问MySQL的方式,优点和缺点是完全一样的:使用显示的SQL语句操作数据库。

优点:直接、方便代码Review和性能检查

缺点:SQL编写过程繁琐、易错,特别是对于CRUD请求,效率较低

Spring Boot集成SQL数据库2

Spring Boot 集成 MyBatis操作MySQL

MyBatis是一款半自动的ORM框架。由于某国内大厂的广泛使用,MyBatis在国内非常火热(在国外其热度不如Hibernate)。

首先还是集成依赖:

implementation 'org.mybatis.spring.boot:mybatis-spring-boot-starter:2.2.0'

implementation 'mysql:mysql-connector-java:8.0.20'

套路与jdbc类似,但starter并不是官方的了,而是mybatis自己做的starter,感兴趣的可以来这里看下具体组成(会有惊喜)。

接下来是yaml配置环节:

spring.datasource:

url: jdbc:mysql://127.0.0.1:3306/homs_demo?useUnicode=true&characterEncoding=UTF-8&useSSL=false

username: HomsDemo

password: 123456

hikari:

minimumIdle: 10

maximumPoolSize: 100

# mybatis extra

mybatis:

configuration:

map-underscore-to-camel-case: true

type-aliases-package: com.coder4.homs.demo.server.mybatis.dataobject

不难发现,数据库链接的定义复用了jdbc的那一套,MyBatis的定义分3行,如下:

-

configuration:开启驼峰规则转化

-

type-aliases-package:mapper文件存放的包名

更多MyBatis的配置选项可以参考[这里](mybatis-spring-boot-autoconfigure – Introduction)

接着,我们定义Mapper,在MyBatis中,Mapper相当于前面手写的Repository,定义如下:

package com.coder4.homs.demo.server.mybatis.mapper;

import com.coder4.homs.demo.server.mybatis.dataobject.UserDO;

import org.apache.ibatis.annotations.Mapper;

import org.apache.ibatis.annotations.Param;

import org.springframework.stereotype.Repository;

/**

* <p>

* Mapper 接口

* </p>

*

* @author author

* @since 2021-09-09

*/

@Repository

@Mapper

public interface UserMapper {

@Insert("INSERT INTO users(name) VALUES(#{name})")

@Options(useGeneratedKeys = true, keyProperty = "id")

long create(UserDO user);

@Select("SELECT * FROM users WHERE id = #{id}")

UserDO getUser(@Param("id") Long id);

@Select("SELECT * FROM users WHERE name = #{name}")

UserDO getUserByName(@Param("name") String name);

}

你可能会奇怪:这不是接口(interface)么,并没有实现?

是的,通过定义@Repository和@Mapper,MyBatis会通过运行时的切面注入,帮我们自动实现,具体执行的SQL和映射,会读取@Select、@Options等注解中的配置。

经过上述介绍,你可以发现:

MyBatis可以直接通过注解的方式快速访问数据库,(相对于JDBC的)精简了大量无用代码。

同时,MyBatis依然需要指定运行的SQL语句,这与JDBC的方式是一致的。虽然有些繁琐,但可以保证性能可控。

如果你在网上搜索"MyBatis Spring集成",会找到大量xml配置的用法。

在一些老项目中,xml是标准的集成方式。在这种配置方式下,配置繁琐、代码量大,即使借助"MyBatisX"等插件,也依然较为复杂。

因此,除非你要维护遗留的老项目代码,我都建议你使用(本文中)注解式集成MyBatis。

Spring Boot集成 JPA 操作MySQL

JPA的全称是Java Persistence API,即持久化访问规范API。

Spring也提供了集成JPA的方案,称为 Spring Data JPA,其底层是通过Hibernate的JPA来实现的。

首先集成依赖:

implementation 'org.springframework.boot:spring-boot-starter-data-jpa'

implementation 'mysql:mysql-connector-java:8.0.20'

与前面类似,不再重复介绍。

接着是配置:

# jdbc demo

spring.datasource:

url: jdbc:mysql://127.0.0.1:3306/homs_demo?useUnicode=true&characterEncoding=UTF-8&useSSL=false

username: HomsDemo

password: 123456

hikari:

minimumIdle: 10

maximumPoolSize: 100

# jpa demo

spring.jpa:

database-platform: org.hibernate.dialect.MySQL8Dialect

hibernate.ddl-auto: validate

在MySQL连接上,我们依然复用了Spring DataSource的配置。

jpa侧的配置为:

-

database-platform:设置使用MySQL8语法

-

hibernate.ddl-auto:只校验表,不回主动更新数据表的结构

接着,我们来定义实体(Entity):

@Entity

@Data

@Table(name = "users")

public class UserEntity {

@Id

@GeneratedValue(strategy = GenerationType.IDENTITY)

private long id;

// @Column(name = "name")

private String name;

public User toUser() {

User user = new User();

user.setId(id);

user.setName(name);

return user;

}

}

这里我们将UserEntity与表"users"做了关联。

接下来是Repository:

@Repository

public interface UserJPARepository extends CrudRepository<UserEntity, Long> {

Collection<UserEntity> findByName(String name);

}

我们继承了CrudRepository,他会自动生成针对UserEntity的CRUD操作。

此外,我们还定义了1个额外函数:

- findByName,通过隐士语法规则,让JPA自动帮我们生成对应SQL

从直观感受上,JPA比MyBatis更加“高级” -- 一些简单的SQL都不用写了。

但天下真的有免费的馅饼么?我们先卖个关子。

JMJ应该选哪个

经过这两节的介绍,你已经掌握了JDBC、MyBatis、JPA三种操作数据库的方式。

在实战中,究竟要选哪个呢?

从易用性的角度来评估,我们可以得出结论:JPA > MyBatis > JDBC

那么从性能的角度来看呢?

我们使用wrk做了(get-by-id接口的)简单压测,结论如下:

| 读QPS | |

|---|---|

| JDBC | 457 |

| MyBatis | 445 |

| JPA | 114 |

这里,你会惊讶的发现:

-

JDBC和MyBatis的性能差别不大,在5%以内

-

JPA(Hibernate)的性能,居然只有其余两种方式的1/3

如此差的性能,真的让人百思不得其解,我尝试打印了SQL和执行耗时,并没有发现什么异常。

更进一步的,我们尝试用指定SQL的方式,替换了自动生成的接口,如下

@Repository

public interface UserJPARepository extends CrudRepository<UserEntity, Long> {

@Query(value = "SELECT * FROM users WHERE id = :id", nativeQuery = true)

Optional<UserEntity> findByIdFast(@Param("id") long id);

}

这次的压测结果是:447,性能基本和JDBC持平了。但是这种NativeSQL的用法并没有使用自动生成SQL的功能,没有发挥Hibernate本来的功效。

所以,我们认为,锅在于Hibernate自动生成SQL的逻辑耗时过大。

当然,Hibernate也不是一无是处,针对多层关联,建模复杂的场景,使用Entity做映射,会更加方便。

让我们回到前面的问题上:JMJ应该选哪个?

-

如果对性能有极致要求,建议JDBC或者MyBatis。

-

如果建模场景复杂,嵌套密集,且对性能要求不高,可以选用Hibernate。

Spring Boot集成gRPC框架

gRPC是谷歌开源的高性能、开源、通用RPC框架。由于gRPC基于HTTP2协议,所以其对移动端非常友好。

本节将介绍Spring Boot集成gRPC的服务端、客户端。

安装protoc及gRPC

gRPC默认使用[Protocol Buffers](Protocol Buffers | Google Developers)做为序列化协议,我们首先安装protoc编译器:

在这里下载最新版本的protoc编译器,请根据你的操作系统选择对应版本,这里我选用MacOSX的。

wget https://github.com/protocolbuffers/protobuf/releases/download/v3.17.3/protoc-3.17.3-osx-x86_64.zip

unzip protoc-3.17.3-osx-x86_64.zip

解压缩后,将其加入PATH路径下:

export PATH=$PATH:$YOUR_PROTOC_PATH

试一下是能否执行:

protoc --version

libprotoc 3.17.3

除此之外,我们还需要一个gRPC的Java插件,才能生成gRPC的桩代码,你可以在[这里](Maven Central Repository Search)找到最新版本。这里我们依然选择OSX的64位版本:

wget https://search.maven.org/remotecontent?filepath=io/grpc/protoc-gen-grpc-java/1.40.1/protoc-gen-grpc-java-1.40.1-osx-x86_64.exe

下载后,将其加入PATH路径中。尝试定位一下:

which protoc-gen-grpc-java

Your_Path/protoc-gen-grpc-java

至此,protoc和grpc的安装准备工作已经就绪。

Client侧集成

首先是集成依赖,我们放在client子项目的builld.gradle中:

implementation 'com.google.protobuf:protobuf-java:3.17.3'

implementation "io.grpc:grpc-stub:1.39.0"

implementation "io.grpc:grpc-protobuf:1.39.0"

implementation 'io.grpc:grpc-netty-shaded:1.39.0'

由于版本依赖较多,我建议使用platform统一管理,可以参考前文。

接着,我们编写protoc文件,HomsDemo.proto:

syntax = "proto3";

option java_package = "com.coder4.homs.demo";

option java_outer_classname = "HomsDemoProto";

;

message AddRequest {

int32 val1 = 1;

int32 val2 = 2;

}

message AddResponse {

int32 val = 1;

}

message AddSingleRequest {

int32 val = 1;

}

service HomsDemo {

rpc Add(AddRequest) returns (AddResponse);

rpc Add2(stream AddSingleRequest) returns (AddResponse);

}

我们添加了两个RPC方法:

-

Add是正常的调用

-

Add2是单向Stream调用

接着,我们需要编译,生成桩文件:

#!/bin/sh

DIR=`cd \`dirname ${BASH_SOURCE[0]}\`/.. && pwd`

protoc HomsDemo.proto --java_out=${DIR}/homs-demo-client/src/main/java --proto_path=${DIR}/homs-demo-client/src/main/java/com/coder4/homs/demo/

protoc HomsDemo.proto --plugin=protoc-gen-grpc-java=`which protoc-gen-grpc-java` --grpc-java_out=${DIR}/homs-demo-client/src/main/java --proto_path=${DIR}/homs-demo-client/src/main/java/com/coder4/homs/demo/

这里分为两个步骤:

-

第一次protoc编译,生成protoc的桩文件

-

第二次protoc编译,使用了protoc-gen-grpc-java的插件,生成gRPC的服务端和客户端文件

编译成功后,路径如下:

homs-demo-client

├── build.gradle

└── src

└── main

└── java

└── com

└── coder4

└── homs

└── demo

├── HomsDemo.proto

├── HomsDemoGrpc.java

└── HomsDemoProto.java

如上所示:HomsDemoProto是protoc的桩文件,HomsDemoGrpc是gRPC服务的桩文件。

下面我们来编写客户端代码,HomsDemoClient.java:

package com.coder4.homs.demo.client;

import com.coder4.homs.demo.HomsDemoGrpc;

import com.coder4.homs.demo.HomsDemoProto.AddRequest;

import com.coder4.homs.demo.HomsDemoProto.AddResponse;

import com.coder4.homs.demo.HomsDemoProto.AddSingleRequest;

import io.grpc.Channel;

import io.grpc.ManagedChannel;

import io.grpc.ManagedChannelBuilder;

import io.grpc.StatusRuntimeException;

import io.grpc.stub.StreamObserver;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import java.util.Arrays;

import java.util.Collection;

import java.util.Optional;

import java.util.concurrent.CountDownLatch;

import java.util.concurrent.TimeUnit;

import java.util.concurrent.atomic.AtomicLong;

/**

* @author coder4

*/

public class HomsDemoClient {

private Logger LOG = LoggerFactory.getLogger(HomsDemoClient.class);

private final HomsDemoGrpc.HomsDemoBlockingStub blockingStub;

private final HomsDemoGrpc.HomsDemoStub stub;

/**

* Construct client for accessing HelloWorld server using the existing channel.

*/

public HomsDemoClient(Channel channel) {

blockingStub = HomsDemoGrpc.newBlockingStub(channel);

stub = HomsDemoGrpc.newStub(channel);

}

public Optional<Integer> add(int val1, int val2) {

AddRequest request = AddRequest.newBuilder().setVal1(val1).setVal2(val2).build();

AddResponse response;

try {

response = blockingStub.add(request);

return Optional.ofNullable(response.getVal());

} catch (StatusRuntimeException e) {

LOG.error("RPC failed: {0}", e.getStatus());

return Optional.empty();

}

}

public Optional<Integer> add2(Collection<Integer> vals) {

try {

CountDownLatch cdl = new CountDownLatch(1);

AtomicLong respVal = new AtomicLong();

StreamObserver<AddSingleRequest> requestStreamObserver =

stub.add2(new StreamObserver<AddResponse>() {

@Override

public void onNext(AddResponse value) {

respVal.set(value.getVal());

}

@Override

public void onError(Throwable t) {

cdl.countDown();

}

@Override

public void onCompleted() {

cdl.countDown();

}

});

for (int val : vals) {

requestStreamObserver.onNext(AddSingleRequest.newBuilder().setVal(val).build());

}

requestStreamObserver.onCompleted();

try {

cdl.await(1, TimeUnit.SECONDS);

} catch (InterruptedException e) {

e.printStackTrace();

}

return Optional.ofNullable(respVal.intValue());

} catch (StatusRuntimeException e) {

LOG.error("RPC failed: {0}", e.getStatus());

return Optional.empty();

}

}

}

代码如上所示:Add还是相对简单的,但是使用了Stream的Add2就比较复杂了。

在上述代码中,需要传入Channel做为连接句柄,在假设知道IP和端口的情况下,可以如下构造:

String target = "127.0.0.1:5000";

ManagedChannel channel = null;

try {

channel = ManagedChannelBuilder

.forTarget(target)

.usePlaintext()

.build();

} catch (Exception e) {

LOG.error("open channel excepiton", e);

return;

}

HomsDemoClient client = new HomsDemoClient(channel);

在微服务架构下,实例众多,获取每个IP显得不太实际,我们会在后续章节介绍集成服务发现的Channel构造方案。

Server侧集成

老套路,首先是依赖集成:

implementation 'com.google.protobuf:protobuf-java:3.17.3'

implementation "io.grpc:grpc-stub:1.39.0"

implementation "io.grpc:grpc-protobuf:1.39.0"

implementation 'io.grpc:grpc-netty-shaded:1.39.0'

与上述客户端的集成完全一致。

接下来我们实现RPC的服务逻辑:

/**

* @(#)HomsDemoImpl.java, 8月 12, 2021.

* <p>

* Copyright 2021 coder4.com. All rights reserved.

* CODER4.COM PROPRIETARY/CONFIDENTIAL. Use is subject to license terms.

*/

package com.coder4.homs.demo.server.grpc;

import com.coder4.homs.demo.HomsDemoGrpc.HomsDemoImplBase;

import com.coder4.homs.demo.HomsDemoProto.AddRequest;

import com.coder4.homs.demo.HomsDemoProto.AddResponse;

import com.coder4.homs.demo.HomsDemoProto.AddSingleRequest;

import io.grpc.stub.StreamObserver;

/**

* @author coder4

*/

public final class HomsDemoGrpcImpl extends HomsDemoImplBase {

@Override

public void add(AddRequest request, StreamObserver<AddResponse> responseObserver) {

responseObserver.onNext(AddResponse.newBuilder()

.setVal(request.getVal1() + request.getVal2())

.build());

responseObserver.onCompleted();

}

@Override

public StreamObserver<AddSingleRequest> add2(StreamObserver<AddResponse> responseObserver) {

return new StreamObserver<AddSingleRequest>() {

int sum = 0;

@Override

public void onNext(AddSingleRequest value) {

sum += value.getVal();

}

@Override

public void onError(Throwable t) {

}

@Override

public void onCompleted() {

responseObserver.onNext(AddResponse.newBuilder()

.setVal(sum)

.build());

sum = 0;

responseObserver.onCompleted();

}

};

}

}

这里要特别说明,因为gRPC都是异步回调的方式,所以其RPC在实现上有点反直觉:

-

通过responseObserver.onNext返回调用结果

-

通过responseObserver.onCompleted结束调用

而add2方法,由于采用了Client-Streaming,所以实现会更加复杂一些。

实际上,gRPC支持[4种调用模式](Generated-code reference | Java | gRPC):

-

Unary: 客户端单输入,服务端单输出

-

Client-Streaming: 客户端多输入,服务端单输出

-

Server-Streaming: 客户端单输入,服务端多输出

-

Bidirectional-Streaming: 客户端多输入,服务端多输出

由于篇幅所限,本文种只实现了前2种,推荐你手动实现另外的两种模式。

Spring Boot集成Redis内存数据库

常规的业务数据,一般选择存储在SQL数据库中。

传统的SQL数据库基于磁盘存储,可以正常的流量需求。然而,在高并发应用场景中容易被拖垮,导致系统崩溃。

针对这种情况,我们可以通过增加缓存、使用NoSQL数据库等方式进行优化。

Redis是一款开源的内存NoSQL数据库,其稳定性高、[性能强悍](How fast is Redis? – Redis),是KV细分领域的市场占有率冠军。

本节将介绍Redis与Spring Boot的集成方式。

Redis环境准备

与前文类似,我们使用Docker快速部署Redis服务器。

#!/bin/bash

NAME="redis"

PUID="1000"

PGID="1000"

VOLUME="$HOME/docker_data/redis"

mkdir -p $VOLUME

docker ps -q -a --filter "name=$NAME" | xargs -I {} docker rm -f {}

docker run \

--hostname $NAME \

--name $NAME \

--volume "$VOLUME":/data \

-p 6379:6379 \

--detach \

--restart always \

redis:6 \

redis-server --appendonly yes --requirepass redisdemo

在上述脚本中:

-

使用了最新的redis 6镜像

-

开启"appendonly"的持久化方式

-

启用密码"redisdemo"

-

端口暴露为6379

我们尝试连接一下:

redis-cli -h 127.0.0.1 -a redisdemo

成功!(如果你没有redis-cli的可执行文件,可以到官网下载)

Redis的缓存使用

Spring提供了内置的Cache框架,可以通过@Cache注解,轻松实现redis Cache的功能。

首先引入依赖:

implementation 'org.springframework.boot:spring-boot-starter-data-redis'

implementation 'org.springframework.boot:spring-boot-starter-json'

implementation 'org.apache.commons:commons-pool2:2.11.0'

上述依赖的作用分别为:

-

redis客户端:Spring Boot 2使用的是lettuce

-

json依赖:我们要使用jackson做json的序列化 / 反序列化

-

commons-pool2线程池,这里其实是data-redis没处理好,需要额外加入,按理说应该集成在starter里的

接着我们在application.yaml中定义数据源:

# redis demo

spring:

redis:

host: 127.0.0.1

port: 6379

password: "redisdemo"

lettuce:

pool:

max-active: 50

min-idle: 5

接着我们需要设置自定义的Configuration:

package com.coder4.homs.demo.server.configuration;

import com.fasterxml.jackson.annotation.JsonAutoDetect;

import com.fasterxml.jackson.annotation.PropertyAccessor;

import com.fasterxml.jackson.databind.ObjectMapper;

import com.fasterxml.jackson.databind.ObjectMapper.DefaultTyping;

import com.fasterxml.jackson.databind.jsontype.impl.LaissezFaireSubTypeValidator;

import org.springframework.cache.annotation.CachingConfigurerSupport;

import org.springframework.cache.annotation.EnableCaching;

import org.springframework.cache.interceptor.KeyGenerator;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.data.redis.cache.RedisCacheConfiguration;

import org.springframework.data.redis.serializer.Jackson2JsonRedisSerializer;

import org.springframework.data.redis.serializer.RedisSerializationContext;

import java.time.Duration;

/**

* @author coder4

*/

@Configuration

@EnableCaching

public class RedisCacheCustomConfiguration extends CachingConfigurerSupport {

@Bean

public KeyGenerator keyGenerator() {

return (target, method, params) -> {

StringBuilder sb = new StringBuilder();

// sb.append(target.getClass().getName());

sb.append(target.getClass().getSimpleName());

sb.append(":");

sb.append(method.getName());

for (Object obj : params) {

sb.append(obj.toString());

sb.append(":");

}

sb.deleteCharAt(sb.length() - 1);

return sb.toString();

};

}

@Bean

public RedisCacheConfiguration redisCacheConfiguration() {

Jackson2JsonRedisSerializer<Object> serializer = new Jackson2JsonRedisSerializer<Object>(Object.class);

ObjectMapper objectMapper = new ObjectMapper();

objectMapper.setVisibility(PropertyAccessor.ALL, JsonAutoDetect.Visibility.ANY);

objectMapper.activateDefaultTyping(LaissezFaireSubTypeValidator.instance, DefaultTyping.NON_FINAL);

// use json serde

serializer.setObjectMapper(objectMapper);

return RedisCacheConfiguration.defaultCacheConfig()

.entryTtl(Duration.ofMinutes(5)) // 5 mins ttl

.serializeValuesWith(RedisSerializationContext.SerializationPair.fromSerializer(serializer));

}

}

上述主要包含两部分:

-

KeyGenerator可以根据Class + method + 参数 生成唯一的key名字,用于Redis中存储的key

-

RedisCacheConfiguration做了2处定制:

-

更改了序列化方式,从默认的Java(Serilization更改为Jackson(json)

-

缓存过期时间为5分钟

-

接着,我们在项目中使用Cache

public interface UserRepository {

Optional<Long> create(User user);

@Cacheable(value = "cache")

Optional<User> getUser(long id);

Optional<User> getUserByName(String name);

}

这里我们用了@Cache注解,"cache"是key的前缀

访问一下:

curl http://127.0.0.1:8080/users/1

然后看一下redis

redis-cli -a redisdemo

> keys *

> "cache::UserRepository1Impl:getUser1"

> get "cache::UserRepository1Impl:getUser1"

"[\"com.coder4.homs.demo.server.model.User\",{\"id\":1,\"name\":\"user1\"}]"

> ttl "cache::UserRepository1Impl:getUser1"

> 293

数据被成功缓存在了Redis中(序列化为json),并且会自动过期。

我们使用Spring Boot集成SQL数据库2一节中的压测脚本验证性能,QPS达到860,提升达80%。

在数据发生删除、更新时,你需要更新缓存,以确保一致性。推荐你阅读[缓存更新的套路](缓存更新的套路 | 酷 壳 - CoolShell)。

在更新/删除方法上应用@CacheEvict(beforeInvocation=false),可以实现更新时删除的功能。

Redis的持久化使用

Redis不仅可以用作缓存,也可以用作持久化的存储。

首先请确认Redis已开启持久化:

127.0.0.1:6379> config get save

1) "save"

2) "3600 1 300 100 60 10000"

127.0.0.1:6379> config get appendonly

1) "appendonly"

2) "yes"

上述分别为rdb和aof的配置,有任意一个非空,即表示开启了持久化。

实际上,在我们集成Spring Data的时候,会自动配置RedisTemplte,使用它即可完成Redis的持久化读取。

不过默认配置的Template有一些缺点,我们需要做一些改造:

package com.coder4.homs.demo.server.configuration;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.context.annotation.Configuration;

import org.springframework.data.redis.core.RedisTemplate;

import org.springframework.data.redis.serializer.RedisSerializer;

import org.springframework.data.redis.serializer.StringRedisSerializer;

/**

* @author coder4

*/

@Configuration

public class RedisTemplateConfiguration {

@Autowired

public void decorateRedisTemplate(RedisTemplate redisTemplate) {

RedisSerializer stringSerializer = new StringRedisSerializer();

redisTemplate.setKeySerializer(stringSerializer);

redisTemplate.setKeySerializer(stringSerializer);

redisTemplate.setValueSerializer(stringSerializer);

redisTemplate.setHashKeySerializer(stringSerializer);

redisTemplate.setHashValueSerializer(stringSerializer);

}

}

如上所述,我们设置RedisTemplate的KV,分别采用String的序列化方式。

接着我们在代码中使用其存取Redis:

@Autowired

private RedisTemplate redisTemplate;

redisTemplate.boundValueOps("key").set("value");

RedisTemplate的语法稍微有些奇怪,你也可以直接使用Conn来做操作,这样更加"Lettuce"。

@Autowired

private LettuceConnectionFactory leconnFactory;

try (RedisConnection conn = leconnFactory.getConnection()) {

conn.set("hehe".getBytes(), "haha".getBytes());

}

至此,我们已经完成了Spring Boot 与 Redis的集成。

思考题:当一个微服务需要连接多组Redis,该如何集成呢?

请自己探索,并验证其正确性。

微服务开发中篇:微服务的注册与发现、配置中心、消息队列、稳定性

你可能留意到,在"微服务上篇"的讨论中,我们介绍的RPC、数据库等内容,都局限于单机环境,并没有真正涉及“分布式”。

在本章,我们将"真正的"进入分布式的微服务实战开发。

在微服务的架构下,经过服务的拆分,会形成复杂的服务调用关系,例如A调用B,B调用C....调用Z。同时,出于性能考虑,每一个服务X可能由若干个实例组成。如此庞大的实例数量,如果依靠手工配置来管理,是一个不可能完成的任务。为此,我们需要引入微服务的注册中心。

我们将基于Nacos来实现服务的注册与发现:Nacos的基本用法、服务端的自动注册,客户端的自动发现、装配。

Nacos不仅是服务管理平台,也提供了配置管理的功能,我们将基于此实现微服务的配置中心。

消息队列是应用接耦、流量消峰的利器,我们将介绍Rocket MQ的基础概念,并将其集成进开发框架中。

保证微服务的稳定性有三大法宝:“熔断、限流、降级”。在本章的最后,我们将引入轻量但强大的resilience4j,为微服务保驾护航。

Nacos注册中心:注册篇

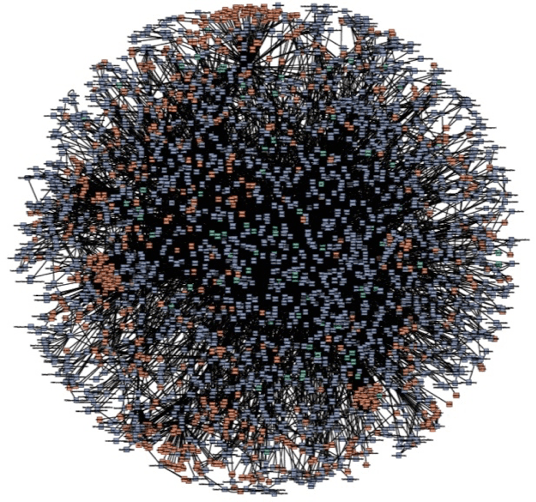

这是一张从互联网上找到的图,你的直观感受是什么?头皮发麻?

实际上,这个球儿是某一年亚马逊的微服务结构图,每一个球的端点,都是一个微服务。

假设某个微服务A,想通过RPC调用另一个微服务B,需要如何实现呢?

-

微服务B可能有多个实例,他需要先找到一个存活的实例,假设叫做B1。

-

需要知道B1的IP和端口

-

建立连接,发起请求,并响应结果。

仔细揣摩上述流程,你会有一些疑问:

-

怎么知道B的哪个实例还在存活?

-

怎么知道B1的具体IP和端口?

-

假设微服务B扩容后,有一个新的B6,如何上服务A感知到呢?

这些都是微服务注册中心要解决的问题。

Nacos服务注册中心

Nacos 致力于帮助您发现、配置和管理微服务。它提供了一组简单易用的特性集,帮助应用快速实现动态服务发现、服务配置、服务元数据及流量管理。

为了演示基本原理,我们将采用单机模式,在实际生产环境中,建议你采用集群部署。

#!/bin/bash

NAME="nacos"

PUID="1000"

PGID="1000"

docker ps -q -a --filter "name=$NAME" | xargs -I {} docker rm -f {}

docker run \

--hostname $NAME \

--name $NAME \

-e MODE=standalone \

-p 8848:8848 \

-p 9848:9848 \

-p 9849:9849 \

--detach \

--restart always \

nacos/nacos-server:2.0.3

如上,我们采用官方镜像的单机模式,端口介绍如下:

-

8848是web界面和rest api端口

-

9848、9849是gRPC端口

启动成功后,访问http://127.0.0.1:8848,会进入如下界面:

默认的用户名和密码都是nacos。

服务端集成Nacos自动注册

接下来,我们实现微服务的自动注册,即服务启动时,将自身的IP和端口,主动注册到Nacos上。

由于我们的架构体系中,通过gRPC进行服务通信,因此我们只注册RPC的部分。我们沿用第2章中的设定,端口是5000。

在服务端集成Nacos有很多方法,一般常见的都是直接使用spring-cloud-starter,但本书并没有采用这种做法,原因是:

-

需要引入大量额外的cloud包,导致技术依赖过于旁杂。

-

cloud模式采用注解的方式,并不能很好支持"一个微服务与多个不同微服务通信"的场景。

综上我们直接使用裸客户端的方式,首先是依赖:

implementation 'com.alibaba.nacos:nacos-client:2.0.3'

接着,我们在第2章的基础上,在RPC服务上做如下修改:

@Configuration

public class RpcServerConfiguration {

private Logger LOG = LoggerFactory.getLogger(RpcServerConfiguration.class);

@Autowired

private BindableService bindableService;

@Autowired

private HomsRpcServer server;

@Autowired

private NacosService nacosService;

@Bean

public HomsRpcServer createRpcServer() {

return new HomsRpcServer(bindableService, 5000);

}

@PostConstruct

public void postConstruct() throws IOException, NacosException {

server.start();

// register

nacosService.registerRPC(SERVICE_NAME);

}

@PreDestroy

public void preDestory() throws NacosException {

try {

server.stop();

} catch (InterruptedException e) {

LOG.info("stop gRPC server exception", e);

} finally {

// unregister

nacosService.deregisterRPC(SERVICE_NAME);

LOG.info("stop gRPC server done");

}

}

}

如上所示,我们在RPC服务启动的时候,增加了向Nacos的注册、在RPC停止的时候,在Nacos上注销服务。

NacosService是对NacosClient的简单封装,代码如下:

@Service

public class NacosServiceImpl implements NacosService {

@Value("${nacos.server}")

private String nacosServer;

private NamingService namingService;

@PostConstruct

public void postConstruct() throws NacosException {

namingService = NamingFactory

.createNamingService(nacosServer);

}

@Override

public void registerRPC(String serviceName) throws NacosException {

namingService.registerInstance(serviceName, getIP(), 5000);

}

@Override

public void deregisterRPC(String serviceName) throws NacosException {

namingService.deregisterInstance(serviceName, getIP(), 5000);

}

private String getIP() {

return System.getProperty("POD_IP", "127.0.0.1");

}

}

如上所示,我们从yaml中读取Nacos服务的地址,然后从环境变量读取IP地址,并实现了注册、注销功能。

这里,你可以暂时假定环境变量一定可以取到IP,在后续Kubernetes的章节,我们会介绍如何将Pod的IP注入容器的环境变量。

你可以试着启动服务,然后访问Nacos的Web UI,会发现我们的服务正常发现了!

至此,我们实现了服务端的服务注册。至于另一半,服务的发现,请听下回分解!

Nacos注册中心:发现篇

经过上一节的努力,我们已经将RPC服务成功的注册到Nacos上了。

我们还是以老生常谈的A调用B为例,B的所有实例B1、B2...都在Nacos上了。我们本节要实现的,都客户端,也就是A的部分。

老规矩,先引入依赖:

implementation 'com.alibaba.nacos:nacos-client:2.0.3'

implementation 'org.springframework.boot:spring-boot-autoconfigure:2.2.0.RELEASE'

上述除了引入nacos的依赖外,还引入了spring-boot的自动配置包,后续做客户端的自动装配时会用到。

客户端改造

在正式对接Nacos前,我们先对客户端的包做一些改造。

首先,引入一个通用的Grpc客户端实现:

public abstract class HSGrpcClient implements AutoCloseable {

private ManagedChannel channel;

private String ip;

private int port;

public HSGrpcClient(String ip, int port) {

this.ip = ip;

this.port = port;

}

public void init() {

channel = ManagedChannelBuilder

.forTarget(ip + ":" + port)

.usePlaintext()

.build();

initSub(channel);

}

protected abstract void initSub(Channel channel);

public void close() throws InterruptedException {

channel.shutdownNow().awaitTermination(5, TimeUnit.SECONDS);

}

}

代码如上所示:

-

HSGrpcClient管理了ManagedChannel,这是用于实际网络通信的连接池。

-

提供了initStub抽象方法,让子类根据自己的需求,去初始化自己的stub。

-

实现了AutoCloseable接口,让客户端可以通过close方法自动关闭。

在这个基础上,我们改造之前的具体RPC客户端,如下:

public class HomsDemoGrpcClient extends HSGrpcClient {

private Logger LOG = LoggerFactory.getLogger(HomsDemoGrpcClient.class);

private HomsDemoGrpc.HomsDemoFutureStub futureStub;

/**

* Construct client for accessing HelloWorld server using the existing channel.

*/

public HomsDemoGrpcClient(String ip, int port) {

super(ip, port);

}

@Override

protected void initSub(Channel channel) {

futureStub = HomsDemoGrpc.newFutureStub(channel);

}

public Optional<Integer> add(int val1, int val2) {

AddRequest request = AddRequest.newBuilder().setVal1(val1).setVal2(val2).build();

try {

AddResponse response = futureStub.add(request).get();

return Optional.ofNullable(response.getVal());

} catch (Exception e) {

LOG.error("grpc add exception", e);

return Optional.empty();

}

}

}

如上,我们改用了FutureStub,并且将Manage的管理部分,移到了基类中。

SimpleGrpcClientManager的实现

在正式引入Nacos之前,我们先实现一个“看起来没什么营养”的SimpleGrpcClientManager,它可以提供IP、Port直连的客户端管理。

首先是基类:

public abstract class AbstractGrpcClientManager<T extends HSGrpcClient> {

protected Logger LOG = LoggerFactory.getLogger(getClass());

protected volatile CopyOnWriteArrayList<T> clientPools = new CopyOnWriteArrayList<>();

protected Class<T> kind;

public AbstractGrpcClientManager(Class<T> kind) {

this.kind = kind;

}

public Optional<T> getClient() {

if (clientPools.size() == 0) {

return Optional.empty();

}

int pos = ThreadLocalRandom.current().nextInt(clientPools.size());

return Optional.ofNullable(clientPools.get(pos));

}

public abstract void init() throws Exception;

public void shutdown() {

clientPools.forEach(c -> {

try {

shutdown(c);

} catch (InterruptedException e) {

LOG.error("shutdown client exception", e);

}

});

}

protected void shutdown(HSGrpcClient client) throws InterruptedException {

client.close();

}

protected Optional<HSGrpcClient> buildHsGrpcClient(String ip, int port) {

try {

Class[] cArg = {String.class, int.class};

HSGrpcClient client = kind.getDeclaredConstructor(cArg)

.newInstance(ip, port);

client.init();

return Optional.ofNullable(client);

} catch (Exception e) {

LOG.error("build MyGrpcClient exception, ip = "+ ip + " port = "+ port, e);

return Optional.empty();

}

}

}

代码如上,解释一下:

- clientPools是一组HSGrpcClient对象,即支持同时与多个微服务实例(多组不同的ip和端口)建立连接。在微服务场景下,这一特性尤为重要。

- 而从每一个HSGrpcClient的视角来看,其内置的ManagedChannel内部实现了连接池。因此针对同一个微服务的ip和端口,我们只需要一个HSGrpcClient的实例即可。

下面,我们看一下基础的、不带服务发现的实现:

package com.coder4.homs.demo.client;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import java.util.Arrays;

import java.util.concurrent.CopyOnWriteArrayList;

/**

* @author coder4

*/

public class SimpleGrpcClientManager<T extends HSGrpcClient> extends AbstractGrpcClientManager<T> {

protected Logger LOG = LoggerFactory.getLogger(SimpleGrpcClientManager.class);

private String ip;

private int port;

public SimpleGrpcClientManager(Class<T> kind, String ip, int port) {

super(kind);

this.ip = ip;

this.port = port;

}

public void init() {

// init one client only

HSGrpcClient client = buildHsGrpcClient(ip, port)

.orElseThrow(() -> new RuntimeException("build HsGrpcClient fail"));

clientPools = new CopyOnWriteArrayList(Arrays.asList(client));

}

public static void main(String[] args) throws Exception {

SimpleGrpcClientManager<HomsDemoGrpcClient> manager = new SimpleGrpcClientManager(HomsDemoGrpcClient.class, "127.0.0.1", 5000);

manager.init();

manager.getClient().ifPresent(t -> System.out.println(t.add(1, 2)));

manager.shutdown();

}

}

从上述实现中不难发现:

-

该实现中,默认只与预先设定的IP和端口,构造一个单独的HSGrpcClient。

-

由于IP和端口通过外部指定,因此使用了CopyOnWriteArrayList以保证线程安全。

NacosGrpcClientManager的实现

下面,我们着手实现带Nacos服务发现的版本。

package com.coder4.homs.demo.client;

import com.alibaba.nacos.api.naming.NamingFactory;

import com.alibaba.nacos.api.naming.NamingService;

import com.alibaba.nacos.api.naming.listener.NamingEvent;

import com.alibaba.nacos.api.naming.pojo.Instance;

import java.util.ArrayList;

import java.util.List;

import java.util.concurrent.CopyOnWriteArrayList;

/**

* @author coder4

*/

public class NacosGrpcClientManager<T extends HSGrpcClient> extends AbstractGrpcClientManager<T> {

protected String serviceName;

protected String nacosServer;

protected NamingService namingService;

public NacosGrpcClientManager(Class<T> kind, String nacosServer, String serviceName) {

super(kind);

this.nacosServer = nacosServer;

this.serviceName = serviceName;

}

@Override

public void init() throws Exception {

namingService = NamingFactory

.createNamingService(nacosServer);

namingService.subscribe(serviceName, e -> {

if (e instanceof NamingEvent) {

NamingEvent event = (NamingEvent) e;

rebuildClientPools(event.getInstances());

}

});

rebuildClientPools(namingService.selectInstances(serviceName, true));

}

private void rebuildClientPools(List<Instance> instanceList) {

ArrayList<HSGrpcClient> list = new ArrayList<>();

for (Instance instance : instanceList) {

buildHsGrpcClient(instance.getIp(), instance.getPort()).ifPresent(c -> list.add(c));

}

CopyOnWriteArrayList<T> oldClientPools = clientPools;

clientPools = new CopyOnWriteArrayList(list);

// destory old ones

oldClientPools.forEach(c -> {

try {

c.close();

} catch (InterruptedException e) {

LOG.error("MyGrpcClient shutdown exception", e);

}

});

}

}

解释如下:

-

在init方法中,初始化了NamingService,并订阅对应serviceName服务的更新事件。

-

当第一次,或者有服务更新时,我们会根据最新列表,重建所有的HSGrpcClient

-

每次重建后,关闭老的HSGrpcClient

为了让上述客户端使用更加方便,我们添加了如下的自动配置:

@Configuration

public class HomsDemoGrpcClientManagerConfiguration {

@Bean(name = "homsDemoGrpcClientManager")

@ConditionalOnMissingBean(name = "homsDemoGrpcClientManager")

@ConditionalOnProperty(name = {"nacos.server"})

public AbstractGrpcClientManager<HomsDemoGrpcClient> nacosManager(

@Value("${nacos.server}") String nacosServer) throws Exception {

NacosGrpcClientManager<HomsDemoGrpcClient> manager =

new NacosGrpcClientManager<>(HomsDemoGrpcClient.class,

nacosServer, HomsDemoConstant.SERVICE_NAME);

manager.init();

return manager;

}

}

如上所示:

-

nacos的server地址由yaml中配置

-

serviceName由client包中的常量文件HomsDemoConstant提供(即homs-demo)

为了让上述自动配置自动生效,我们还需要添加META-INF/spring.factories文件

org.springframework.boot.autoconfigure.EnableAutoConfiguration=\

com.coder4.homs.demo.configuration.HomsDemoGrpcClientManagerConfiguration

最后,我们来实验一下服务发现的效果

-

启动Server进程,检查Nacos上,应当出现了自动注册的RPC服务。

-

开发客户端驱动的项目,引用上述client包、配置yaml中的nacos服务地址

-

最后,在客户端驱动项目中,通过Autowired自动装配,代码类似:

@Autowired

private AbstractGrpcClientManager<HomsDemoGrpcClient> homsClientManager;

// Usage

homsClientManager.getClient().ifPresent(client -> client.add(1, 2));

如果一切顺利,会自动发现nacos上已经注册的服务实例,并成功执行rpc调用。

Spring Boot集成配置中心

Nacos不仅提供了服务的注册与发现,也提供了配置管理的功能。

本节,我们继续使用Nacos,基于其配置管理的功能,实现微服务的配置中心。

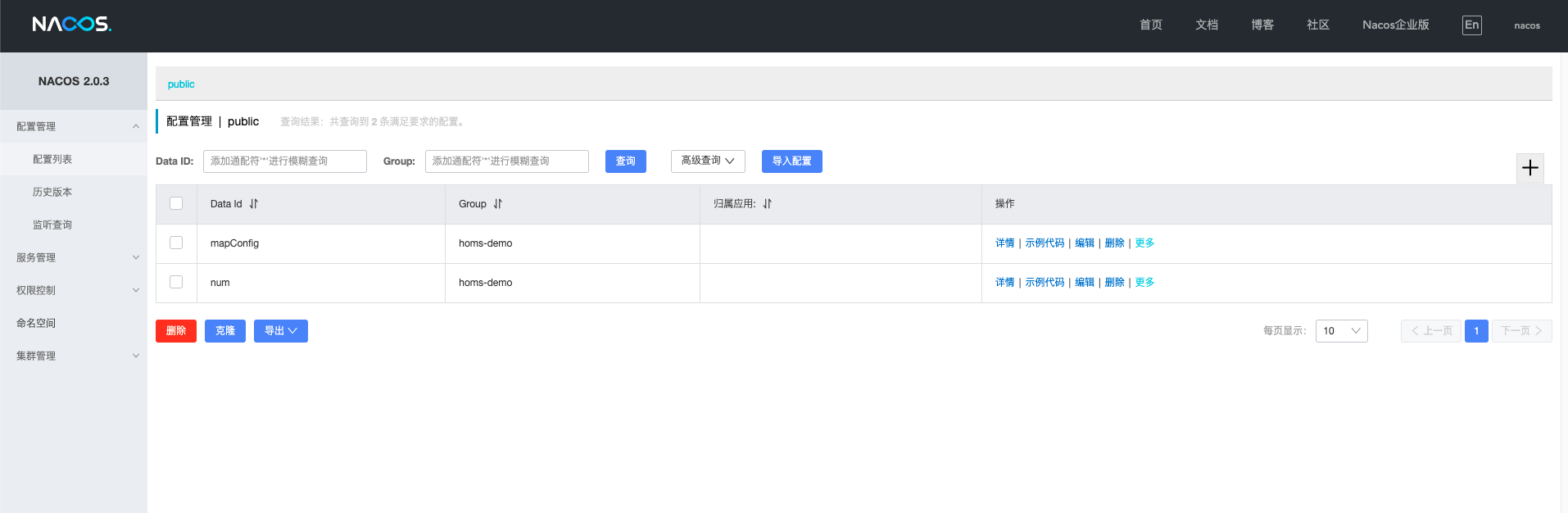

首先,我们在Nacos上,新建两个配置:

如上图所示:

-

Nacos提供了dataId、group两个字段,用于区分不同的配置

-

我们在group字段填充微服务的名称,例如homs-demo

-

我们在dataId字段填写配置的key

-

Nacos的支持简单的类型检验,例如json、数值、字符串等,但只限于前端校验,存储后多统一为字符串类型

有了配置后,我们来实现Nacos配置管理的驱动部分:

public interface NacosConfigService {

Optional<String> getConfig(String serviceName, String key);

void onChange(String serviceName, String key, Consumer<Optional<String>> consumer);

}

package com.coder4.homs.demo.server.service.impl;

import com.alibaba.nacos.api.NacosFactory;

import com.alibaba.nacos.api.config.ConfigService;

import com.alibaba.nacos.api.config.listener.Listener;

import com.alibaba.nacos.api.exception.NacosException;

import com.coder4.homs.demo.server.service.spi.NacosConfigService;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.stereotype.Service;

import javax.annotation.PostConstruct;

import java.util.Optional;

import java.util.concurrent.Executor;

import java.util.function.Consumer;

/**

* @author coder4

*/

@Service

public class NacosConfigServiceImpl implements NacosConfigService{

private static final Logger LOG = LoggerFactory.getLogger(NacosConfigServiceImpl.class);

@Value("${nacos.server}")

private String nacosServer;

private ConfigService configService;

@PostConstruct

public void postConstruct() throws NacosException {

configService = NacosFactory

.createConfigService(nacosServer);

}

@Override

public Optional<String> getConfig(String serviceName, String key) {

try {

return Optional.ofNullable(configService.getConfig(key, serviceName, 5000));

} catch (NacosException e) {

LOG.error("nacos get config exception for " + serviceName + " " + key, e);

return Optional.empty();

}

}

@Override

public void onChange(String serviceName, String key, Consumer<Optional<String>> consumer) {

try {

configService.addListener(key, serviceName, new Listener() {

@Override

public Executor getExecutor() {

return null;

}

@Override

public void receiveConfigInfo(String configInfo) {

consumer.accept(Optional.ofNullable(configInfo));

}

});

} catch (NacosException e) {

LOG.error("nacos add listener exception for " + serviceName + " " + key, e);

throw new RuntimeException(e);

}

}

}

上述驱动部分,主要实现了两个功能:

-

通过getConfig方法,同步拉取配置

-

通过onChange方法,添加异步监听器,当配置发生改变时,会执行回调

配置的自动注解与更新

我们希望实现一个更加“易用”的配置中心,期望具有如下特性:

-

通过注解的方式,自动将类中的字段"绑定"到远程Nacos配置中心对应字段上,并自动初始化。

-

当Nacos配置更新后,本地同步进行修改。

-

支持类型的自动转换

第一步,我们声明注解:

package com.coder4.homs.demo.server.annotation;

import java.lang.annotation.Documented;

import java.lang.annotation.ElementType;

import java.lang.annotation.Retention;

import java.lang.annotation.RetentionPolicy;

import java.lang.annotation.Target;

@Target({ElementType.FIELD, ElementType.PARAMETER})

@Retention(RetentionPolicy.RUNTIME)

@Documented

public @interface HSConfig {

String name() default "";

String serviceName() default "";

}

上述关键字段的用途是:

-

name,远程fdc指定的配置名称,可选,若未填写则使用注解应用的原始字段名。

-

serviceName,远程fdc指定的服务名称,可选,若未填写则使用当前本地服务名。

接着,我们借助BeanPostProcessor,来对打了HSConfig注解的字段,进行值注入。

package com.coder4.homs.demo.server.processor;

import com.alibaba.nacos.common.utils.StringUtils;

import com.coder4.homs.demo.server.HsReflectionUtils;

import com.coder4.homs.demo.server.annotation.HSConfig;

import com.coder4.homs.demo.server.service.spi.NacosConfigService;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.aop.support.AopUtils;

import org.springframework.beans.BeansException;

import org.springframework.beans.factory.config.BeanPostProcessor;

import org.springframework.core.Ordered;

import org.springframework.data.util.ReflectionUtils.AnnotationFieldFilter;

import org.springframework.util.ReflectionUtils;

import org.springframework.util.ReflectionUtils.FieldFilter;

import java.lang.reflect.Field;

import java.util.Optional;

/**

* @author coder4

*/

public class HsConfigFieldProcessor implements BeanPostProcessor, Ordered {

private static final Logger LOG = LoggerFactory.getLogger(HsConfigFieldProcessor.class);

private static final FieldFilter HS_CONFIG_FIELD_FILTER = new AnnotationFieldFilter(HSConfig.class);

private NacosConfigService nacosConfigService;

private String serviceName;

public HsConfigFieldProcessor(NacosConfigService service, String serviceName) {

this.nacosConfigService = service;

this.serviceName = serviceName;

}

@Override

public Object postProcessBeforeInitialization(Object bean, String beanName) throws BeansException {

Class targetClass = AopUtils.getTargetClass(bean);

ReflectionUtils.doWithFields(

targetClass, field -> processField(bean, field), HS_CONFIG_FIELD_FILTER);

return bean;

}

private void processField(Object bean, Field field) {

HSConfig valueAnnotation = field.getDeclaredAnnotation(HSConfig.class);

// 优先注解,其次本地代码

String key = StringUtils.defaultIfEmpty(valueAnnotation.name(), field.getName());

String serviceName = StringUtils.defaultIfEmpty(valueAnnotation.serviceName(), this.serviceName);

Optional<String> valueOp = nacosConfigService.getConfig(serviceName, key);

try {

if (!valueOp.isPresent()) {

LOG.error("nacos config for serviceName = {} key = {} is empty", serviceName, key);

}

HsReflectionUtils.setField(bean, field, valueOp.get());

// Future Change

nacosConfigService.onChange(serviceName, key, valueOp2 -> {

try {

HsReflectionUtils.setField(bean, field, valueOp2.get());

} catch (IllegalAccessException e) {

LOG.error("nacos config for serviceName = {} key = {} exception", e);

}

});

} catch (IllegalAccessException e) {

LOG.error("setField for " + field.getName() + " exception", e);

throw new RuntimeException(e.getMessage());

}

}

@Override

public int getOrder() {

return LOWEST_PRECEDENCE;

}

}

上述代码比较复杂,我们逐步讲解:

-

构造函数传入nacosConfigService用于操作nacos配置管理接口

-

构造函数传入的serviceName做为默认的服务名

-

postProcessBeforeInitialization方法,会在Bean构造前执行,通过ReflectionUtils来过滤所有打了@HsConfig注解的字段,逐一处理,流程如下:

-

首先获取要绑定的服务名、字段名,遵循注解优于本地的顺序

-

调用nacosServer拉取当前配置,并通过HsReflectionUtils工具的反射的注入到字段中。

-

添加回调,以便未来更新时,及时修改本地变量。

-

HsReflectionUtils中涉及类型的自动转换,代码如下:

package com.coder4.homs.demo.server.utils;

import com.fasterxml.jackson.core.JsonProcessingException;

import com.fasterxml.jackson.databind.ObjectMapper;

import java.lang.reflect.Field;

/**

* @author coder4

*/

public class HsReflectionUtils {

private static final ObjectMapper OBJECT_MAPPER = new ObjectMapper();

public static void setField(Object bean, Field field, String valueStr) throws IllegalAccessException {

field.setAccessible(true);

Class fieldType = field.getType();

if (fieldType == Integer.TYPE || fieldType == Integer.class) {

field.set(bean, Integer.parseInt(valueStr));

} else if (fieldType == Long.TYPE || fieldType == Long.class) {

field.set(bean, Long.parseLong(valueStr));

} else if (fieldType == Short.TYPE || fieldType == Short.class) {

field.set(bean, Short.parseShort(valueStr));

} else if (fieldType == Double.TYPE || fieldType == Double.class) {

field.set(bean, Double.parseDouble(valueStr));

} else if (fieldType == Float.TYPE || fieldType == Float.class) {

field.set(bean, Float.parseFloat(valueStr));

} else if (fieldType == Byte.TYPE || fieldType == Byte.class) {

field.set(bean, Byte.parseByte(valueStr));

} else if (fieldType == Boolean.TYPE || fieldType == Boolean.class) {

field.set(bean, Boolean.parseBoolean(valueStr));

} else if (fieldType == Character.TYPE || fieldType == Character.class) {

if (valueStr == null || valueStr.isEmpty()) {

throw new IllegalArgumentException("can't parse char because value string is empty");

}

field.set(bean, valueStr.charAt(0));

} else if (fieldType.isEnum()) {

field.set(bean, Enum.valueOf(fieldType, valueStr));

} else {

try {

field.set(bean, OBJECT_MAPPER.readValue(valueStr, fieldType));

} catch (JsonProcessingException e) {

throw new IllegalArgumentException("can't parse json because exception");

}

}

}

}

上述代码中,针对field的类型逐一判断,针对八大基本类型,直接parse,针对复杂类型,使用json反序列化的方式注入。

自动配置的使用

有了上述的基础后,我们还需要添加自动配置类,让其生效:

package com.coder4.homs.demo.server.configuration;

import com.coder4.homs.demo.constant.HomsDemoConstant;

import com.coder4.homs.demo.server.processor.HsConfigFieldProcessor;

import com.coder4.homs.demo.server.service.spi.NacosConfigService;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.autoconfigure.condition.ConditionalOnMissingBean;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

/**

* @author coder4

*/

@Configuration

public class HsConfigProcessorConfiguration {

@Bean

@ConditionalOnMissingBean(HsConfigFieldProcessor.class)

public HsConfigFieldProcessor fieldProcessor(@Autowired NacosConfigService configService) {

return new HsConfigFieldProcessor(configService, HomsDemoConstant.SERVICE_NAME);

}

}

使用时非常简单:

@Service

public class HomsDemoConfig {

@HSConfig

private int num;

@HSConfig(name = "mapConfig")

private Map<String, String> map;

@PostConstruct

public void postConstruct() {

System.out.println(num);

System.out.println(map);

}

}

只需要添加HSConfig注解,即可完成远程配置的自动注入、绑定、更新。

Spring Boot集成熔断、限流、降级

在引入resilience4j之前,我们先来讨论下服务稳定性的三大法宝。

-

降级:在有限资源情况下,为了应对超负荷流量,适当放弃一些功能,以保证服务的整体稳定性。例如:双十一大促时,关闭个性化推荐。

-

限流:为了应对突发流量,只允许一部分请求通过,放弃其余请求。例如:当前服务忙,请稍后再试。

-

熔断:这个概念最早源于物理学。

-

在电路中,若电流过大,熔断器(保险丝 / 空气开关)会发生熔断,切断线路,以保证用电安全。

-

在微服务架构中,若服务调用发生大量错误(超时),可以直接将微服务降级,以保证服务的整体稳定性。

-

Resillence4j是一款轻量级、易用的"容错框架",提供了保证稳定性所需的几大基础组件:

-

Retry:重试

-

Circuit Breaker:基于Ring Buffer的熔断器,根据失败率/次数,自动切换熔断器的开关状态。

-

Rate Limiter:基于AtomicReference + 状态机 实现的限流器

-

Time Limiter:基于限时Future / CompletationStage的时限器

-

Bulk Head:基于信号量 / 线程池的壁仓隔离。

-

Cache / Fallback:为上述组件提供降级时的包装函数

Resillence4j支持Java、注解等多种使用方法,我们这里选用最方便的Spring Boot注解方法。

Circuit Breaker

首先来看一下熔断器,它内置了如下三种状态:

-

CLOSE:初始状态,熔断器关闭,服务正常运行。

-

OPEN:发生大量错误后,熔断器打开,直接返回降级结果,不再调用真实服务逻辑。

-

HALF OPEN:OPEN一段时间后,小流量放开访问,看真实逻辑部分是否恢复正常。如果恢复,会切换到CLOSE状态。

老规矩,先添加依赖:

implementation 'io.github.resilience4j:resilience4j-all:1.7.1'

implementation 'io.github.resilience4j:resilience4j-spring-boot2:1.7.1'

说明如下:

-

由于后续几个组件都会使用,我们这里直接使用了all,你可以根据实际情况,裁剪需要的组件。

-

spring-boot:添加了对应的注解和自动配置。

熔断器的配置如下:

resilience4j:

circuitbreaker:

instances:

getUserById:

registerHealthIndicator: true

slidingWindowSize: 100

failureRateThreshold: 50

说明如下:

-

熔断器名称是getUserById

-

滑动窗口大小100

-

失败(熔断)阀值是50%

代码用法如下:

@Override

@CircuitBreaker(name = "getUser", fallbackMethod = "getUserByIdFallback")

public Optional<User> getUserById(long id) {

// Mock a failure

if (ThreadLocalRandom.current().nextInt(100) < 90) {

throw new RuntimeException("mock failure");

}

return userRepository.getUser(id);

}

public Optional<User> getUserByIdFallback(long id, Throwable e) {

LOG.error("enter fallback for getUserById", e);

return Optional.empty();

}

在上述代码中,我们以90%的概率模拟了随机异常。

当熔断发生时,会使用getUserByIdFallback中的降级结果。

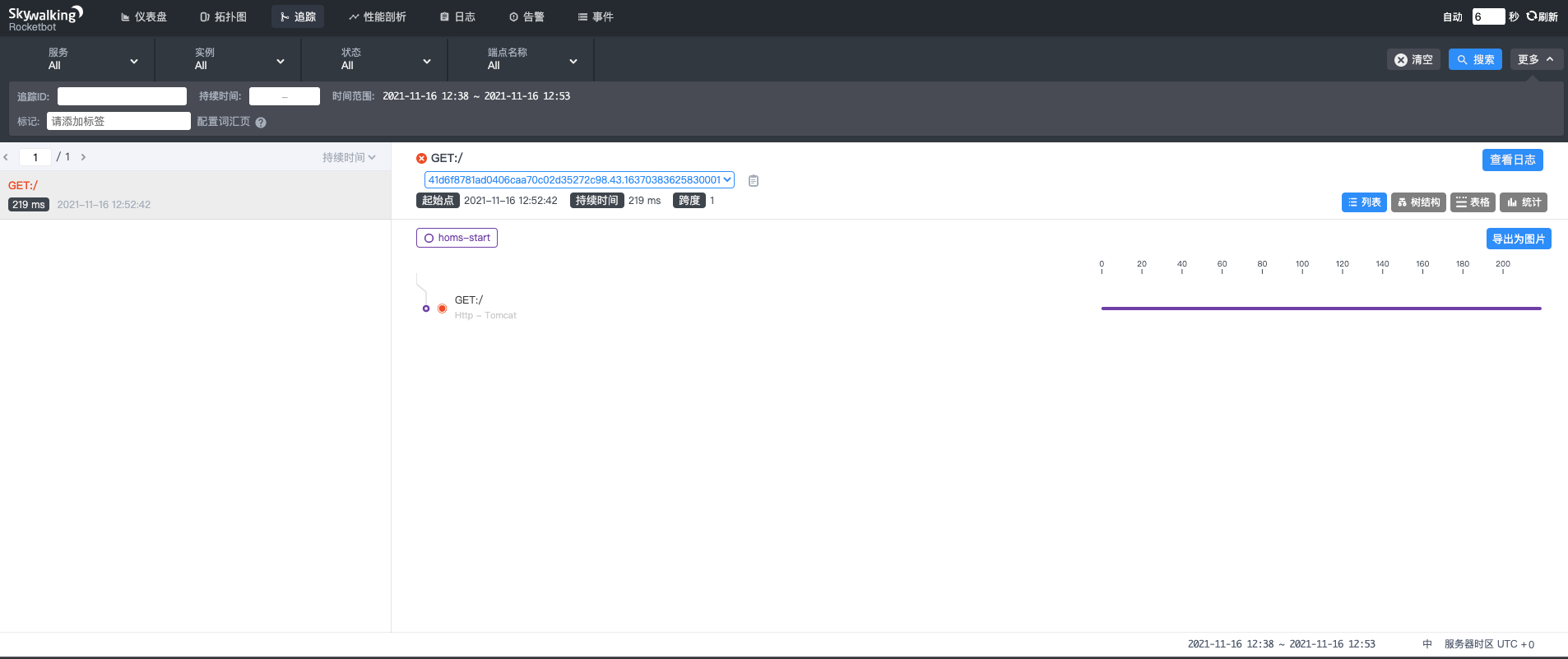

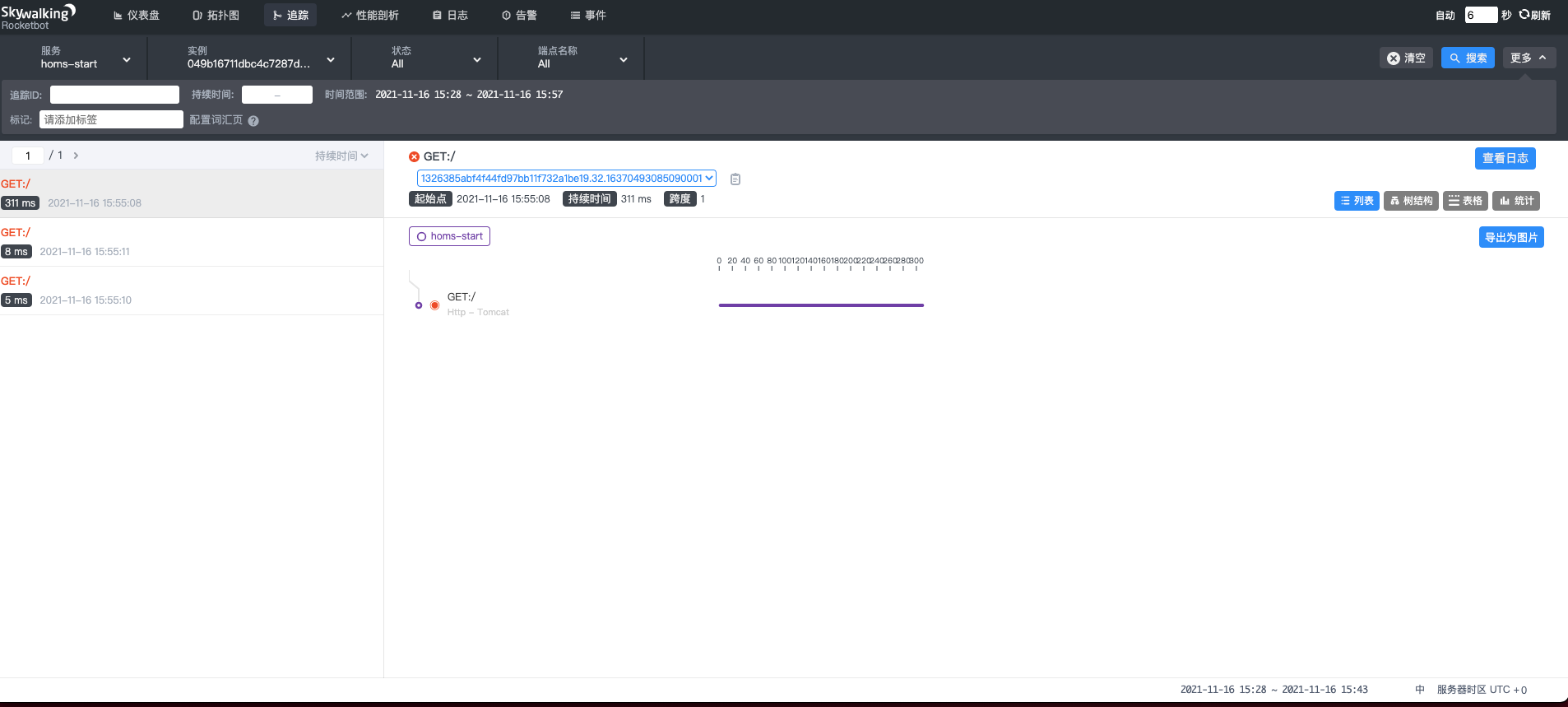

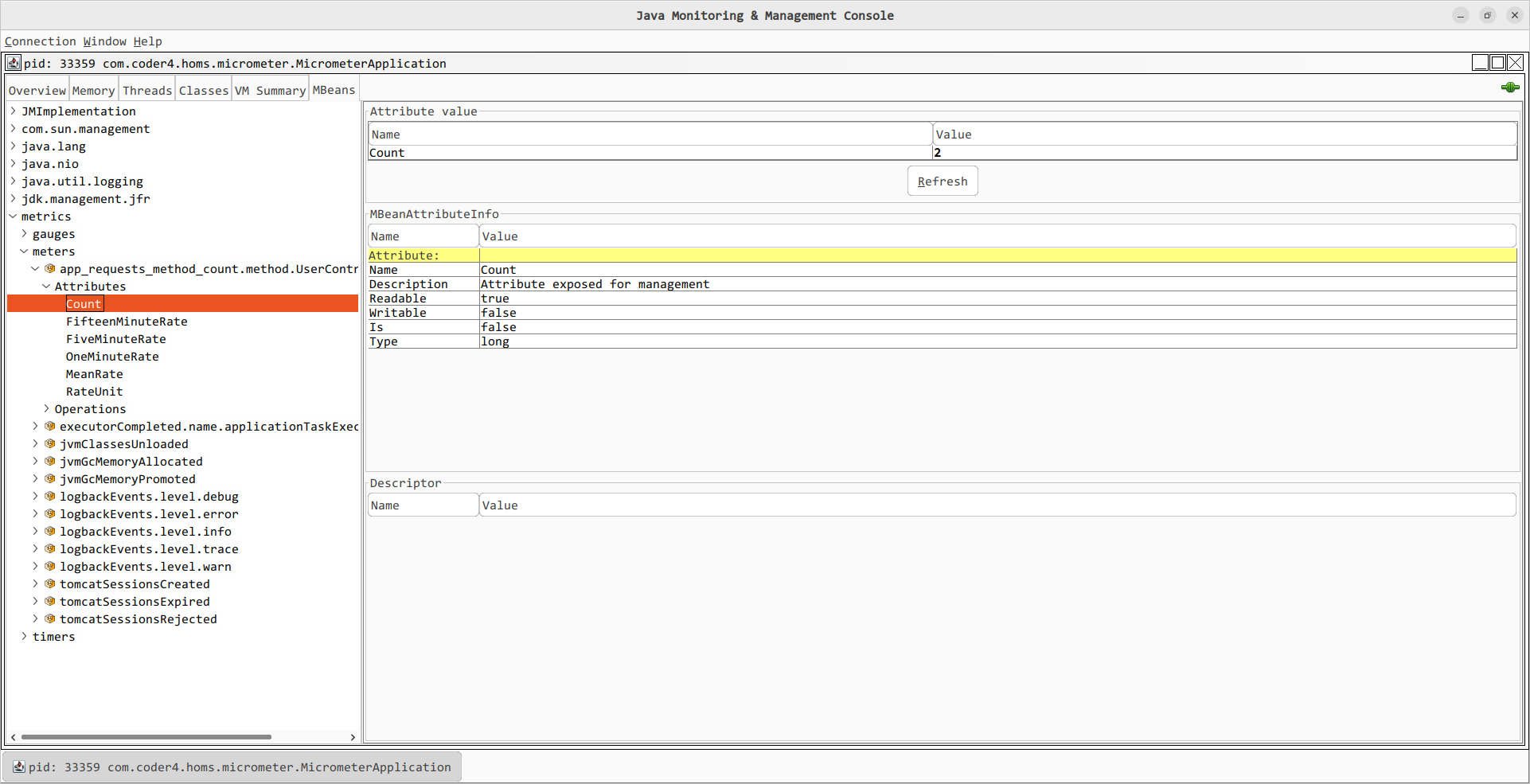

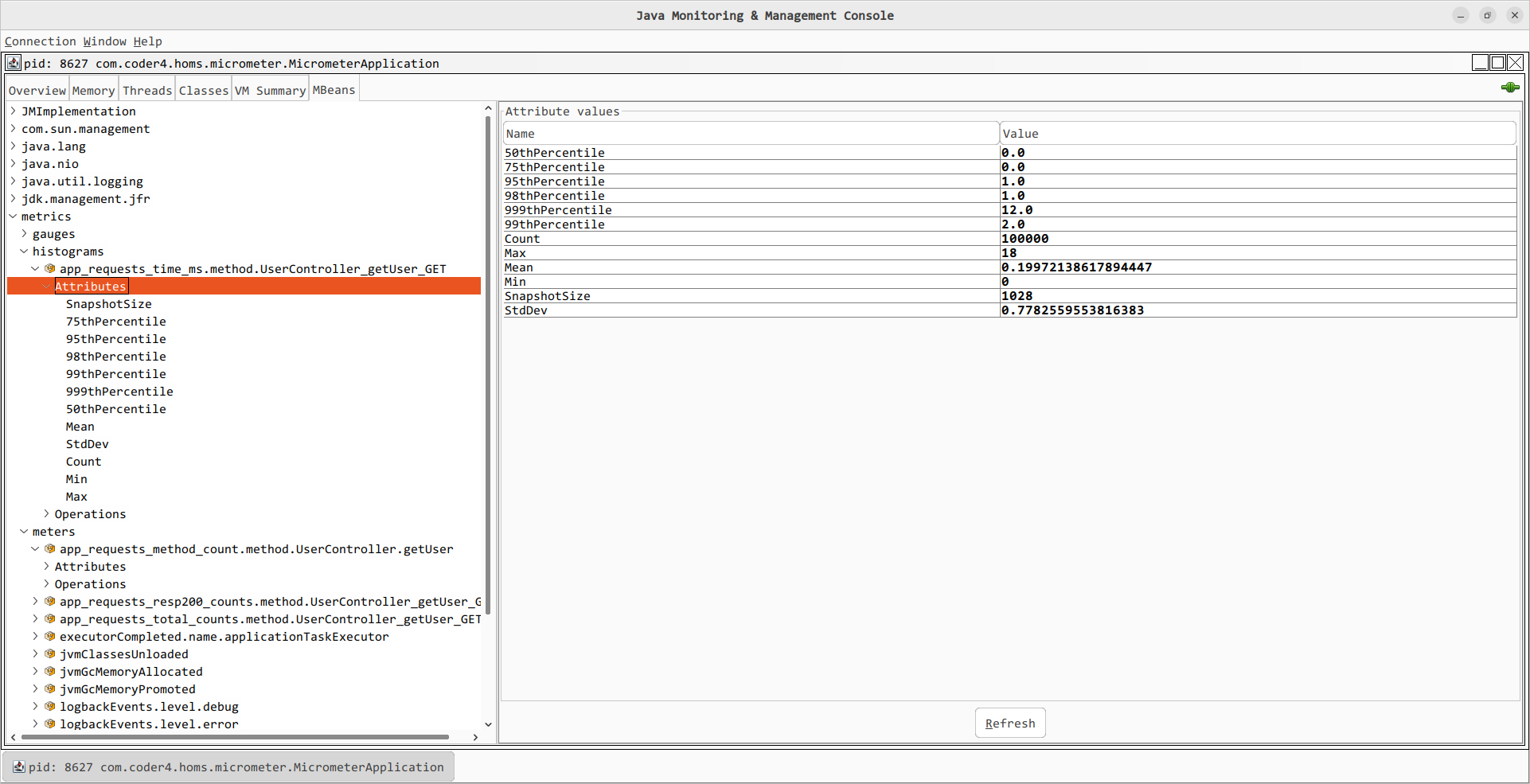

执行几次后,会出现类似如下的错误日志,熔断器已成功开启。